Peux-tu nous parler de ton parcours, et notamment de ce qui t’a conduit à t’intéresser à l’informatique musicale et à l’art génératif ?

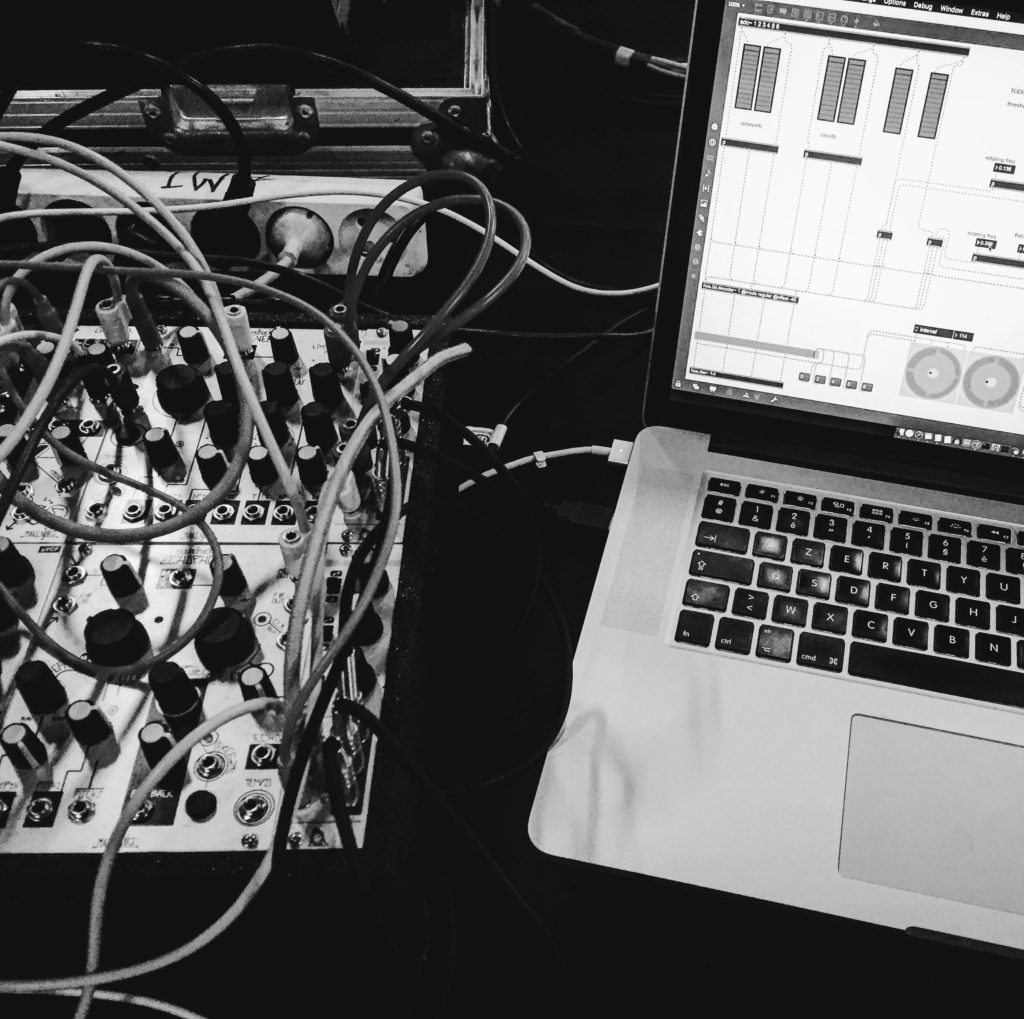

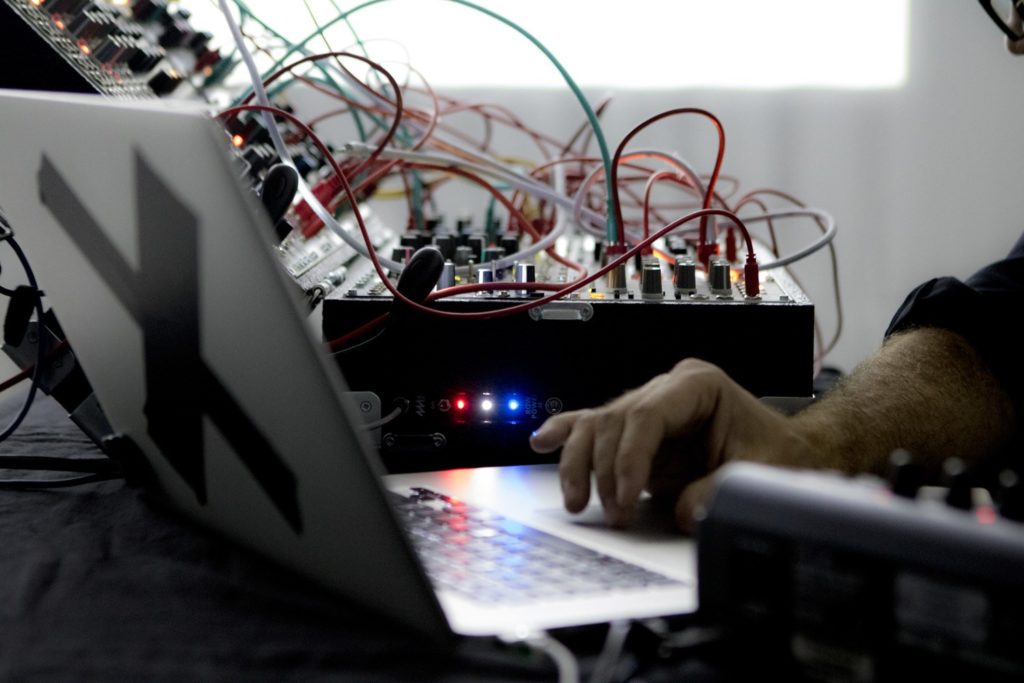

À mes débuts, je manipulais principalement des synthétiseurs analogiques et des séquenceurs. L’aléatoire était absent de mon travail, qui était très écrit, avec beaucoup de boucles… J’avais le sentiment qu’il me manquait quelque chose. Ce qui a été déclencheur, c’est le programme Reason de Propellerheads Software, dans lequel on pouvait “patcher”, un peu comme dans Max/MSP, moduler des éléments entre eux, faire des boucles de rétroaction, et par là générer des comportements un peu chaotiques…

Ce qui m’a intéressé initialement dans l’utilisation de l’informatique pour générer des sons et des images, c’était le contrôle que cela donnait sur les choses. Je pouvais, sans forcément figer une création, écrire un code capable de générer plusieurs œuvres possibles, en décidant d’un faisceau de règles que je pouvais ensuite modifier en live, ou bien leur permettre d’être modifiées par des processus externes. J’aimais ainsi disposer d’une sorte de curseur entre des éléments très contraints, très écrits, et d’autres où je laissais plus de latitude au système pour explorer un territoire donné.

Dans quelle direction tes pièces ont-elles évolué depuis tes premières créations génératives ? Quel serait la pièce dont tu serais le plus satisfait de ce point de vue ?

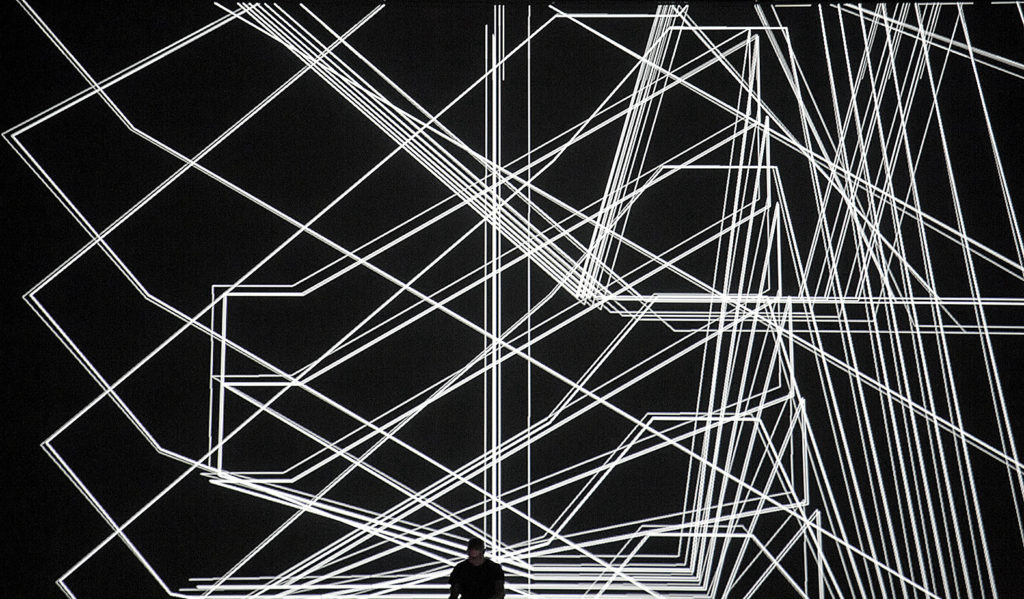

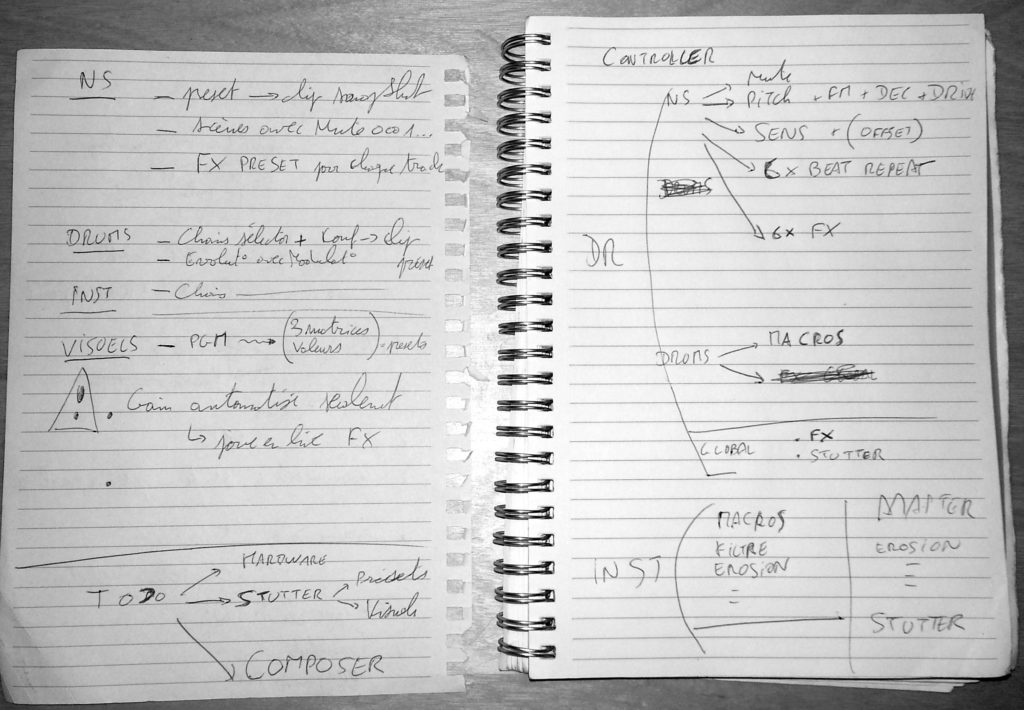

J’évolue vers de systèmes où j’accepte de plus en plus l’influence de choses réelles, que je peux ensuite moduler, combiner avec des sons de synthèse. Dans mes premières créations, je n’enregistrais aucun son. Je conservais uniquement les algorithmes qui permettaient de générer les sons et les séquences. Pour moi, enregistrer un son et l’utiliser, malgré toutes les possibilités de modulation, de découpage et de montage, c’était comme me priver de la possibilité future de le modifier, c’était accepter de ne plus avoir complètement le contrôle sur lui. Depuis mon projet FRGMENTS, qui est à la fois une installation et un live, j’ai davantage ouvert le système aux influences extérieures, je l’ai rendu plus poreux à des choses déjà enregistrées. C’était un tournant qui correspondait aussi à des choses plus personnelles dans ma vie. Dans mon live précédent, ALPHA, tout était généré en live, visuels et sons. ALPHA était en quelque sorte plus fermé, presque recroquevillé sur lui-même, alors que FRGMENTS est ouvert sur le réel. J’y dispose d’un ensemble de sons pré-enregistrés, du field-recording, et je les modifie en live, en ajoutant de la réverbération, en découpant le son à des emplacements aléatoires mais contraints… C’est dans le visuel que la part de l’algorithmique est la plus prépondérante. Je n’y touche pas du tout en live. Le système visuel “écoute” en temps-réel l’évolution du son, fait une analyse du signal, et interprète les paramètres extraits par l’analyse (par exemple selon que le son sera plus ou moins étouffé, plus ou moins brillant) de façon visuelle. Pour moi, l’algorithme qui contrôle les visuels fonctionne comme une sorte de miroir.

Actuellement, je travaille sur un nouveau projet, STRUCTURE.LIVE, qui fait suite à une installation au MIRA Festival à Barcelone l’année dernière. Alors que STRUCTURE.INSTALLATION était entièrement générative, STRUCTURE.LIVE sera basé sur des sons enregistrés, ainsi que des mouvements réels de danseurs captés en studio pour la partie visuelle. Dans FRGMENTS, les images utilisées étaient des visages un peu impassibles, immobiles, tandis que dans STRUCTURE.LIVE, j’inclurai l’humain en mouvement…

Ce qui évolue d’un projet à l’autre, c’est donc l’injection du réel. Je garde beaucoup de générativité, mais, de plus en plus, en interaction avec une matière presque totalement écrite et préparée.

Quel intérêt ont pour toi les techniques génératives ? Quelle pourrait être ta « signature » dans ton utilisation de ces techniques ?

En ce qui concerne les sons, je m’intéresse surtout à la façon dont ils seront déclenchés dans le temps. J’aime remplir une séquence en suivant une progression géométrique non linéaire, par exemple sur une grille exponentielle : des déclencheurs très rapprochés au départ, puis de plus en plus éloignés… C’est une question que j’aimerais explorer davantage par la suite : comment habiter et peupler un intervalle de temps musical sans utiliser une grille régulière ?

Pour l’harmonie, je travaille principalement à l’oreille, même si j’ai toujours un spectroscope dans un coin de l’écran. Ce qui m’intéresse, c’est la façon de remplir le spectre, de travailler séparément fréquences très basses et très hautes par exemple, ou de les superposer à certains moments, dans une approche finalement assez visuelle, comme s’il s’agissait de sculpter une matière en termes de densités.

Certaines de tes oeuvres sont-elles pleinement autonomes une fois activées ?

STRUCTURE.INSTALLATION est un bon exemple. La pièce utilise notamment des synthétiseurs logiciels, qui vont générer du son, et dont les paramètres vont évoluer en fonction d’une dizaine de contextes, autrement dit de moments sonores et visuels. Je décide que pour un contexte donné, les sons auront plutôt un caractère métallique, ou bien évolueront dans un intervalle fréquentiel précis… Le field recording est ici utilisé en tant que tel, sans modification, mais comme un élément qui va venir perturber tous les sons synthétisés, par synthèse croisée : il s’agit de prendre un peu du spectre d’un son pour altérer le spectre d’un autre et créer ainsi de nouvelles textures, à chaque fois légèrement différentes. STRUCTURE.INSTALLATION est en quelque sorte au croisement d’un monde très contrôlé et abstrait, et du monde réel et imparfait, un endroit où les deux s’affrontent. J’ai utilisé pas mal de prises de sons faites dans des lieux où l’on entendait des structures métalliques grincer, être frappées par le vent…

Qu’est-ce qui t’a conduit à t’intéresser à la relation entre le son et l’image ? Le son vient-il toujours au début de ta réflexion ?

Au départ, je viens du son, mais tout s’est très vite imbriqué. Quand je travaille sur un projet, sons et images viennent ensemble, comme un objet unique, une énergie commune. Pour ALPHA, j’ai commencé à travailler en assemblant quelques sons avec des algorithmes, et peu à peu la nécessité de travailler sur le visuel s’est imposée. C’était comme un tressage : je trouvais dans le système visuel une consistance qui répondait déjà aux nouveaux sons que je créais pour le morceau suivant, et ainsi de suite…

FRGMENTS fut créé de manière assez similaire : j’avais l’idée d’une matière visuelle, et de la manière dont elle allait être perturbée par le son. Il n’y a pas un médium prépondérant par rapport à l’autre.

STRUCTURE.LIVE, que je suis en train d’écrire, fonctionne aussi de la même manière. Cet affrontement entre mon monde intérieur et le monde extérieur se fait dans une matière qui est d’emblée audio-visuelle. Il y aura des captations de mouvements avec des kinects ou d’autres systèmes qui mesureront l’espace, la structure, la profondeur d’une pièce, afin de générer des nuages de points qui seront la base des visuels.

Utilises-tu la sonification dans certaines de tes pièces ? le databending ?

Il y a une direction qui était prépondérante pour moi au départ : visualiser le son. C’était l’idée d’ALPHA. Je ressentais le besoin de visualiser le son, comme pour lui donner un autre point d’entrée, offrir une autre manière de le ressentir. Dans FRGMENTS, il y a une matière visuelle en tant que telle : des visages. Mais le son va perturber l’affichage, la lecture des vidéos : il y a donc toujours une « illustration » du son, mais qui se situe à un niveau différent.

Je peux éventuellement me servir de techniques de sonification pour générer des sons, pour produire du matériau, par exemple en utilisant l’évolution de la lumière comme modulation, et ainsi générer des textures que je n’aurais pas pu concevoir autrement. Mais je ne le fais jamais en temps réel, seulement en studio.

Quant au databending, les synthétiseurs modulaires me donnent déjà un ensemble de possibilités tellement infini… Aujourd’hui, j’aurais plutôt tendance à me focaliser un peu, à réduire mes outils sonores : je me sépare de plusieurs plugins, et j’ai même songé à un moment, de façon un peu dogmatique, à retirer l’ordinateur de l’équation, pour la partie sonore. Bien sûr, je suis aussi intéressé par tout ce qui relève des datas. J’ai déjà utilisé des flux twitter pour venir perturber des systèmes, par exemple ; j’avais utilisé cela pour un travail commissionné par le Nouveau Musée National de Monaco nommé DISRUPT!ON. Mais à moins d’une raison précise pour l’utilisation de tel ou tel flux, on retombe rapidement sur de l’aléatoire, quel que soit le flux utilisé. Le problème est le même pour la sonification. A titre individuel, ça a davantage de sens pour moi d’obtenir ce type de résultats avec des synthétiseurs modulaires.

Peux-tu nous parler de ton intérêt pour le parametric design ?

L’architecture paramétrique, que l’on nomme parfois en français « paramétricisme », correspond à une époque où l’on commençait à utiliser des algorithmes pour générer des formes, en indiquant au système des contraintes telles que les résistances ou le volume d’un matériau. On parle aussi de design paramétrique, par exemple, quand on souhaite créer un cadre de vélo très robuste mais avec peu de matière, en injectant ces paramètres dans un système qui se charge de calculer la forme idéale pour qu’il soit très résistant et très léger. Cela fait directement écho à mon travail : j’utilise des algorithmes pour déterminer un nombre donné de déclenchements de sons dans un intervalle de temps, séparés par des valeurs aléatoires, ou un espacement du plus petit au plus grand, etc., et pour générer de la variation.

C’est aussi relié à mon intérêt pour l’espace. Pour STRUCTURE.INSTALLATION, j’ai travaillé en collaboration avec Intorno Labs, un studio qui travaille sur la spatialisation du son. Ils ont créé un système software qui permet à l’artiste de s’affranchir des paramètres de puissance et de positionnement des haut-parleurs dans une salle, pour se concentrer sur ses propres sources sonores et le positionnement virtuel qu’il voudrait leur donner, en disposant de 4 paramètres : x, y, z et la diffusion, la source pouvant être très ponctuelle ou très diffuse, voire complètement absente à un endroit donné, créant, à l’inverse de la directionnalité, des trous dans l’espace sonore. Le système fait donc une sorte de transcription de la pièce composée par l’artiste en fonction des haut-parleurs, de leur puissance, de leur position, permettant ainsi de jouer une pièce de manière presque équivalente dans n’importe quel type d’espace, ce qui est bien sûr très intéressant en termes de production. Par exemple, j’avais fait une pièce (SIG.INT) pour le dôme de la SAT à Montréal, et le portage de la même pièce pour d’autres dômes serait revenu très cher en coûts de production, car mon système était entièrement codé pour le système de la SAT, avec un système d’ambisonie dans Max/MSP qui utilisait la librairie HOA. Ce projet m’a encore plus rapproché de cette idée de composition musicale vue comme une architecture. C’est comme une pièce vide dans laquelle on veut créer une structure. C’est là que le paramétricisme intervient dans ma conception d’espaces sonores.

Dans l’histoire (ou dans la préhistoire) de l’art génératif, de quel musicien ou de quel artiste te sentirais-tu le plus proche ? D’une manière plus générale, quels artistes, écrivains ou musiciens ont eu une importance décisive sur ton travail ?

La musique concrète m’a toujours beaucoup intéressé, notamment le concept d’objet sonore, par sa capacité à élargir le domaine du musical. C’est quelque chose vers quoi mon approche de la matérialité du son me portait, même avant que je découvre ce répertoire.

Je suis de très près le travail de certains labels, comme 12k (le label de Taylor Deupree) ou le label Line, qui diffusent des artistes qu’on peut rattacher au genre de la “lowercase music”. C’est une musique qui se préoccupe de ce qui n’est pas au premier plan, mais plutôt de ce qui est en retrait, de tout ce qui pourrait être de l’ordre du bruit de fond… Le label Raster Noton aussi, même s’il n’existe plus vraiment. Le travail très précis de Carsten Nicolai m’a fortement influencé. J’écoute encore beaucoup de musiques référencées comme étant du Métal, cela se sent dans certains types de sons que j’utilise, le côté brutal que l’on ressent encore dans ALPHA, quelque chose d’asséné presque agressivement à l’audience. Maintenant, je veux davantage accompagner le public vers mon travail, lui donner plus de clefs. Je suis également plus curieux aujourd’hui de la façon dont le public, l’autre, va percevoir l’œuvre. Cela participe aussi à cette ouverture du système vers l’extérieur dont je parlais.

Je suis assez intéressé par certains philosophes qui réfléchissent à notre société, comme Zygmunt Bauman et son concept de société liquide. J’ai l’impression que, dans mon travail, la fragmentation du son et de l’image fait écho à cette fragmentation de la société, cette dissolution du lien social, l’éloignement des individus entre eux. En tout cas, cela m’intéresse davantage que des concepts directement empruntés à la musique, comme des problématiques de métrique musicale par exemple. Je préfère m’inspirer directement de l’observation de l’univers, de la société et aussi de la physique des atomes et molécules…

Quels sont tes projets actuels ? Certains font-ils écho à ces problématiques ?

Ce qui m’occupe principalement c’est le live STRUCTURE.LIVE. Mais je travaille également à d’autres projets : j’ai envie d’enregistrer plus de musique à écouter en tant que telle. Je travaille beaucoup avec des outils faits par K-devices pour Max for Live, outils que je peux aussi modifier pour les adapter à mes propres besoins, connaissant bien les « atomes » Max/MSP desquels ils sont constitués. Mais je me base davantage sur les émotions que sur l’outil. Auparavant, j’avais une approche d’ingénieur, que je fus dans une autre vie, tandis qu’aujourd’hui je suis plutôt guidé par l’observation de qui se trouve autour de moi, et l’intégration de l’imperfection, de l’erreur ; je veux dire : de la vraie erreur mesurée en captant le monde réel, le monde physique et non plus seulement en provoquant l’erreur par la programmation d’algorithmes, par exemple.

(Propos recueillis en février 2019)