Définition

Faites rouler un dé à 6 faces. Imaginez que le 1 correspond à un silence, et les 5 autres faces aux notes d’une gamme pentatonique. Jetez le dé plusieurs fois jusqu’à obtenir une mélodie. Voilà, c’est fait : vous avez réalisé votre première composition algorithmique. Pour cela, il a suffi de deux ingrédients : du hasard (le dé jeté) et surtout des règles du jeu (la correspondance entre les chiffres et les notes). Un algorithme, du nom du mathématicien perse Al-Khwârizmî, est un ensemble de règles destinées à accomplir une tâche ou résoudre un problème. Autrement dit, la composition algorithmique est l’art de créer de la musique en utilisant un ensemble de règles pré-determinées. On peut parler de méta-composition, puisque le compositeur produit un système, un ensemble de règles qui produisent en partie la musique pour lui. Si le hasard fait très souvent partie du processus, il n’est pas toujours indispensable.

L’algorithme peut permettre de déterminer les événements sonores :

- à l’échelle macro (hauteurs, dynamiques, rythmes, phrases, instrumentation, forme)

- à l’échelle micro (synthèse du son, par forme d’onde ou synthèse granulaire par exemple)

Le compositeur Philippe Manoury aime résumer les capacités d’un ordinateur à seulement trois choses : exécuter ce qu’on lui demande, capter des signaux extérieurs et générer des nombres aléatoires. La composition algorithmique, lorsqu’elle est assistée par ordinateur, serait donc l’art d’exploiter le potentiel de ces trois facultés combinées, afin de générer de nouvelles formes musicales.

On parle indifféremment de musique algorithmique, de musique générative (terme notamment utilisé par Brian Eno), ou encore de musique procédurale (terme davantage utilisé dans le domaine de la musique pour jeux vidéo).

La musique algorithmique appartient plus largement aux arts génératifs, ensemble de disciplines s’intéressant à la création graphique, audiovisuelle ou littéraire à partir d’algorithmes.

Frontières

Les principes algorithmiques, comme on le verra plus en détail dans la partie historique, n’ont pas attendu l’essor de l’informatique musicale pour être mis en oeuvre, tant s’en faut. Certains considèrent même les principes “d’improvisation sur le livre”, telle qu’elle était pratiquée par les chantres du XVème siècle, comme une forme prototypique de composition algorithmique.

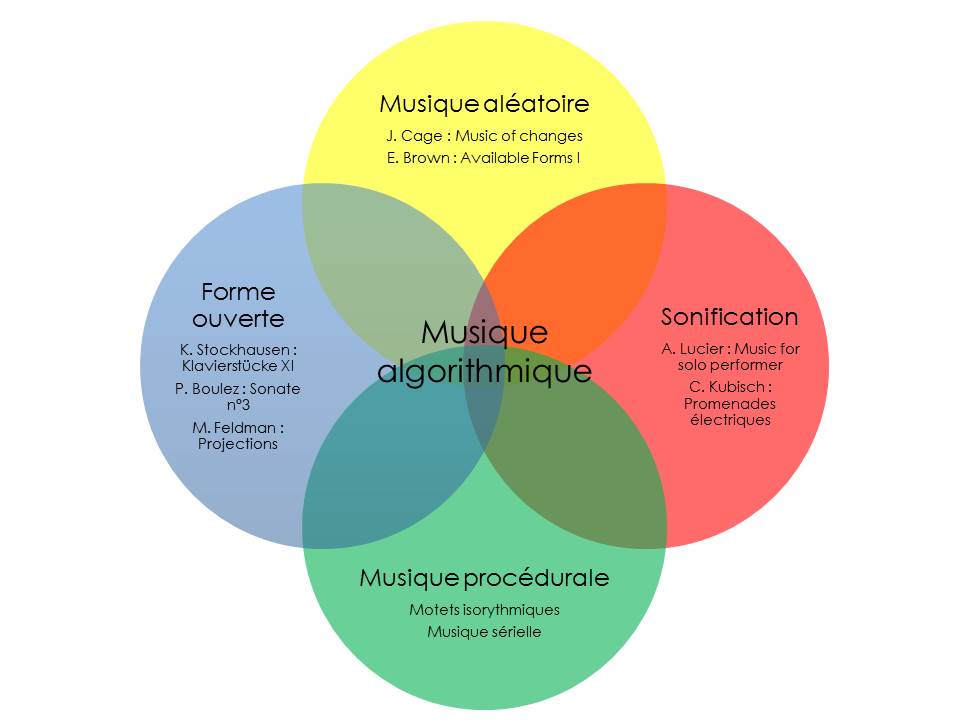

La musique algorithmique peut ainsi emprunter à d’autres formes d’expression musicale certains de ses modes de fonctionnement, notamment :

- la musique aléatoire,

- la forme ouverte

- la sonification.

Historiquement, on fait volontiers remonter les origines de la musique algorithmique aux âges pré-numérique, par les pièces les plus pré-déterminées (motets isorythmiques, constructions contrapuntiques très contraintes, combinatoire sérielle…). Il est frappant que, à l’opposé, l’aléatoire pur (musique au dé d’un John Cage, au tirage de cartes d’un Marcel Duchamp…) soit aussi cité comme précurseur. D’une certaine manière, une distinction relativement comparable se retrouve dans les deux grandes familles de techniques algorithmiques : la composition basée sur des règles et la composition stochastique (utilisant plutôt les probabilités pour contrôler des ensembles d’événements sonores).

Certaines créations musicales jouent de la permutation entre certaines parties de la composition : des “Musikalisches Würfelspiel” (jeux de dés musicaux) du XVIIIe siècle à l’âge d’or de la “forme ouverte” dans les années 60, illustrée notamment par Stockhausen, la combinatoire compte parmi l’arsenal privilégié de la composition algorithmiques.

Enfin, l’exploitation de signaux et de données enregistrées en temps réel ou en différé compte également parmi les procédés les plus utilisés en algorithmique. Au sens strict, on parle de sonification lorsque le résultat sonore est une “représentation” des données, qui doivent être interprétées en tant que telles.

Déterminisme et libre arbitre

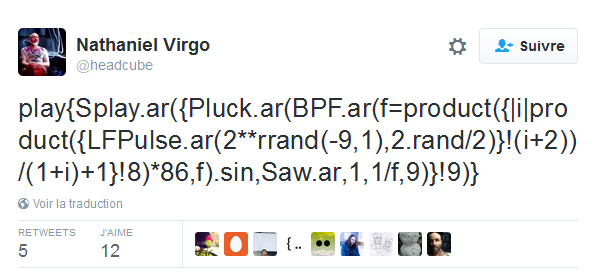

Une composition algorithmique peut être déterministe ou aléatoire. Comme l’écrit Laurent Fichet, “Entre composer et computer, il y a plus de marge que ces deux termes pourraient le laisser croire. Composer suppose une décision, l’emploi du fameux “libre arbitre”, alors que la “computation” ne fait que réagir mécaniquement à des décisions extérieures”. Cela pose la question de la distance entre l’oeuvre et l’algorithme imaginé par l’artiste : y a-t-il identité entre les deux, coïncidence entre la partition et la règle du jeu (“The code is the piece”, pour citer Malcolm McLaren), ou bien l’algorithme n’est-il qu’un moyen ? Ainsi Pierre Barbaud s’obligeait-il à utiliser le résultat brut produit par l’algorithme, ou à modifier et améliorer ce dernier si le résultat ne lui convenait pas (mais, roublard, choisissait la version qui lui convenait le mieux). Le compositeur américain Tom Johnson, qui se situe à la fois dans la continuité de la recherche d’une “musique objective” et dans une forme de minimalisme volontiers provocatrice, revendique également une volonté d’automatisme absolu où “l’intérêt est dans la formule, sa beauté, ou plutôt sa vérité, plus que dans l’oeuvre musicale.” Cette réduction idéale entre le code et sa réalisation sonore immédiate s’accomplit probablement dans les performances de live-coding. Il y a dans la création algorithmique, comme dans le live-coding, une esthétique intrinsèque du codage, la concision et l’élégance du code faisant partie de la beauté du geste artistique.

Au-delà, il peut s’agir d’afficher ainsi le principe, la quintessence d’une œuvre. Il y a quelque chose de fascinant, une beauté en soi, à voir la complexité naître d’ingrédients et de moyens réduits. Une élégance qui n’est pas sans évoquer la notation condensée sous forme d’énigme des canons aux XVIIe et XVIIIe siècle. La composition algorithmique n’étant, en somme, que l’art de réduire au minimum l’intervention du compositeur dans le résultat tout en garantissant la richesse de ce dernier, il est naturel que l’économie des moyens employés puisse en être vu comme l’un des critères d’appréciation.

La question de la diffusion et de la conservation de musiques “purement” génératives reste cependant problématique : le logiciel indispensable pour écouter Generative Music 1 de Brian Eno n’est plus développé, et rares sont les musiciens actuels à proposer des solutions de diffusion de leur création qui ne passe pas par la création de versions figées dans les traditionnels formats wav, aiff ou mp3.

Hasard et perception, répétition et désordre

En matière de création, on manipule généralement des simulations de hasard plus que du hasard véritable. Même le lancé de dé est une action déterministe, qui ne ressemble à du hasard qu’en raison de notre incapacité à connaître l’effet produit par l’énergie du lancé, la surface sur laquelle est jeté le dé, l’angle de tir, etc. Il en va de même pour le pseudo-hasard produit par un ordinateur : les horloges internes des ordinateurs effectuant des calculs au millionième de secondes, la probabilité de trouver le même résultat plusieurs fois de suite est quasi nulle. Le résultat s’apparente donc à du hasard pour notre perception.

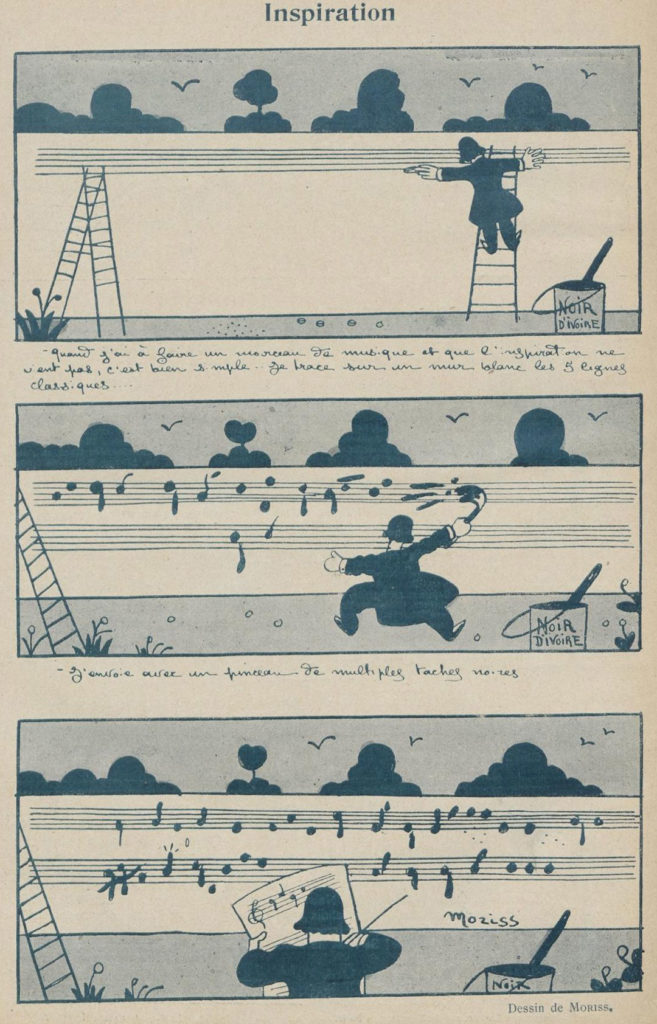

Michel Philippot raconte qu’en 1751, un humoriste anglais du nom de William Hess aurait décrit ainsi “l’art de composer la musique selon une méthode entièrement nouvelle” : “cette méthode consistait à projeter, à l’aide d’une brosse ou d’un pinceau, une pluie de gouttes d’encre sur du papier réglé et à transformer chacune de ces gouttes en notes de musique ! C’était, évidemment, l’emploi du hasard que nous appellerons intégral.” La technique n’est pas sans rappeler le “dripping” cher au peintre américain Jackson Pollock… L’ironie est que, 40 ans après l’article de Michel Philippot, des chercheurs américains découvrent des structures fractales dans les toiles de Pollock, et s’en servent pour départager les vraies toiles du maître de l’expressionnisme abstrait de celles de ses nombreux plagiaires…

Les structures les plus hautement organisées peuvent sembler hasardeuses (ainsi les règles de Golomb, les canons de Vuza…), et réciproquement, le hasard authentique a rarement l’air hasardeux. Il y a un stade où la composition la plus préméditée se confond pour l’auditeur avec l’aléatoire absolu. C’est le constat fait par Iannis Xenakis dans les années 50, renvoyant dos à dos le pointillisme hyper-déterministe de la musique sérielle de l’école de Darmstadt et la musique composée au dé par John Cage. C’est alors qu’il décide d’explorer les ressources du calcul des probabilités pour utiliser un aléatoire dosé, tentant de créer un continuum contrôlé entre ordre et hasard, de parer l’aléatoire de profils spécifiques, donnant ainsi naissance à son concept de stochastique.

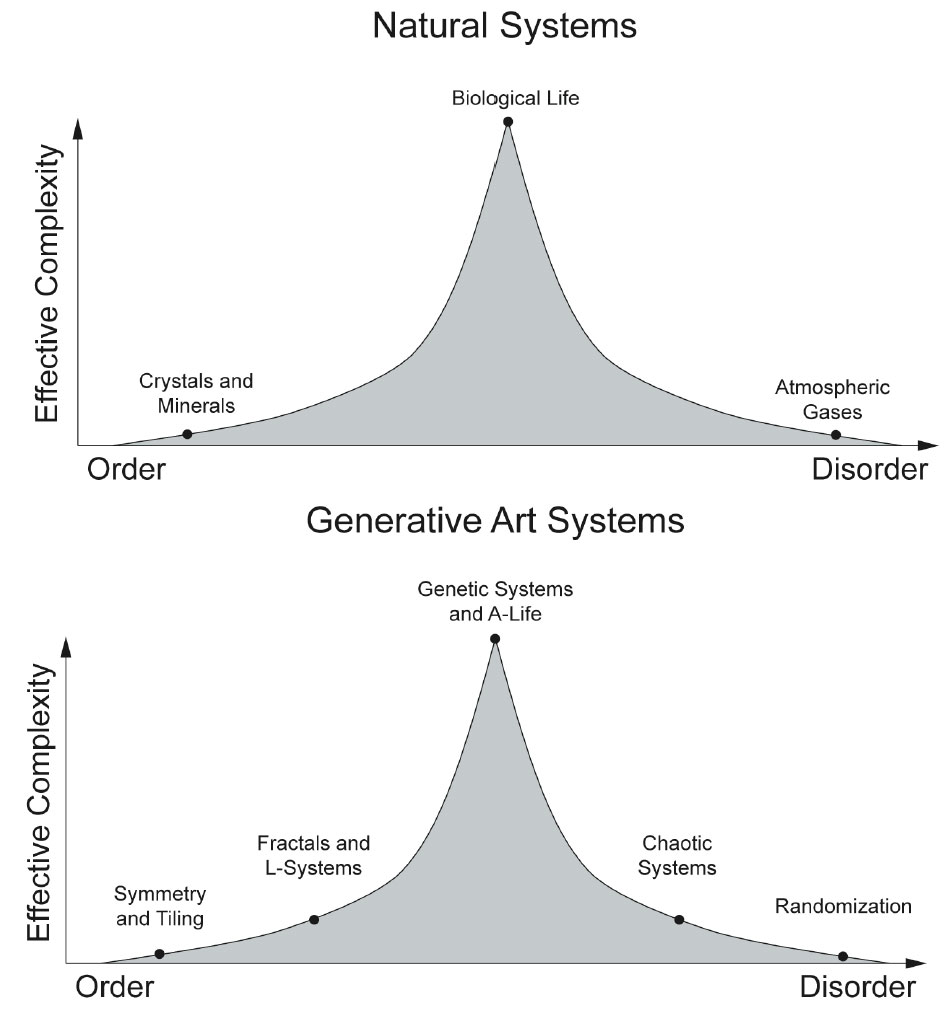

Philip Galanter, dans son article “What is complexism ?” suggère une tension entre ordre et désordre qui serait à l’oeuvre dans les formes de complexité :

La question de la perception doit cependant rester au coeur de la réflexion du compositeur, les constructions formelles issues des algorithmes ne garantissant aucunement d’être perçues comme telles par l’auditeur. Selon le compositeur Fabien Levy, on ne peut pas réduire la complexité perceptive d’une oeuvre à sa complexité analytique, ni l’intérêt perceptif d’une composition musicale à l’intérêt intellectuel de ses structures.

Imitation et modélisation

Avant de commencer à construire son algorithme, il est souvent nécessaire de passer par une étape de modélisation d’une musique pré-existante, au moyen d’outils mathématiques et logiques, ou bien d’utiliser directement des algorithmes tirés de domaines extra-musicaux (notamment le monde du vivant). Cependant, l’imitation n’est pas le but ultime de la composition algorithmique. A ce jeu, la machine a perdu d’avance face au compositeur humain, dont l’oreille a été façonnée par l’écoute de milliers d’heures de musiques. “Imitatores servum pecus !” (“Imitateurs, peuple serf !”), s’exclamait Schopenhauer. Mais en algorithmique comme en synthèse du son (modèle physique, modèles de résonance…), la modélisation d’objets préexistants doit davantage être vue comme un tremplin pour l’imagination, une garantie de créer des modèles riches, qu’un objectif en soi. La composition algorithmique doit se garder de rester prisonnière de cette phase d’imitation. C’est donc dans cet équilibre que se propose de s’inscrire ce travail, entre pure modélisation et exercices d’imagination qui sont in fine la raison d’être de l’algorithmique musicale, qu’elle soit considérée comme un but en soi ou comme une simple escale sur le chemin de la composition. Il n’en reste pas moins que certains outils tendent à être plutôt utilisés dans une logique d’imitation que pour la création originale, notamment les outils issus de l’intelligence artificielle, ou les grammaires génératives.

Lejaren Hiller et Leonard Isaacson avaient d’ailleurs déjà relevé cet écueil que pour composer avec précision dans le style de Beethoven, il faut soit synthétiser un “Beethoven moyen” somme toute assez artificiel, soit restreindre l’analyse aux symphonies, voire à une seule symphonie, à un seul mouvement de symphonie, au risque que finalement seules des variations marginales puissent advenir d’une formalisation stylistique rigoureuse. Il y a parfois un effet de “vallée dérangeante” (Uncanny Valley), lorsque le style se rapproche si étroitement de ce qui aurait pu être créé par un compositeur humain, que la présence de la machine n’en est perçue qu’avec plus d’évidence. La question de l’imitation par un algorithme se heurte rapidement à celle du seuil entre originalité et simple recombinaison d’un matériau pré-existant.

Esthétiquement, l’utilisation des algorithmes n’est pas seulement l’apanage des musiques classiques d’avant-garde. Elle s’illustre aussi bien dans la musique ambient (Brian Eno, Music for airports), ou certaines formes de musiques techno (mouvement des “Algoraves”) que dans certaines musiques de tradition orales (voir par exemple les canons des harpistes Nzakara en République Centrafricaine, étudiées par Marc Chemillier dans Les Mathématiques naturelles, ou encore l’utilisation de l’algorithme de Bjorklund dans plusieurs rythmes de musiques traditionnelles du monde entier). La musique minimaliste se prête aisément à la modélisation. Pas seulement parce que ces œuvres sont délibérément plus simples, mais car le dévoilement des processus sous-jacents de l’oeuvre fait pleinement partie de l’esthétique minimaliste (on parle aussi de “Process music”), en particulier dans la musique américaine du début des années 70 (Pendulum music de Steve Reich, choeurs solfiés dans Einstein on the Beach de Philip Glass, musique d’Alvin Lucier…). Ce n’est donc pas un hasard si certaines figures importantes du minimalisme comme Tom Johnson s’intéressent de près à la musique algorithmique. Une autre esthétique aisément modélisable est celle de la musique sérielle (G. M. Koenig, Karlheinz Essl).

La modélisation mathématique de la musique, quant à elle, doit être manipulée avec précaution. Au-delà de l’écart déjà signalé entre la construction formelle et sa perception, il faut se garder de la tentation de fétichiser l’approche mathématique, si séduisante et rassurante soit-elle. Le théorème de Ramsey pose que “toute suite de nombres aléatoires suffisamment grande possède une sous-suite de nombres régulière en relation harmonique” : autrement dit, la fameuse section d’or si prisée des musiciens peut se trouver, avec un peu de bonne volonté, dans à peu près n’importe quel rapport numérique… Au-delà, la perfection des modèles mathématiques ne doit pas faire oublier que ce qui fait le sel de l’art musical est bien souvent dans l’écart et l’ambiguïté : “Il semble bien qu’en musique, les propriétés intéressantes soient les propriétés indécidables.” (Pierre Chemillier, Monoïdes libres).

Typologie des outils

Nous avons déjà évoqué l’opposition historique entre outils stochastiques et déterministes (où l’algorithme produira le même résultat à chaque fois) :

| Stochastiques | Déterministes |

|---|---|

| Loi de Poisson | Automates cellulaires |

| Chaînes de Markov | L-Systèmes |

| ... | ... |

Mais les techniques plus récentes tendent fréquemment à hybrider les deux tendances : systèmes de neurones artificiels, grammaires génératives…

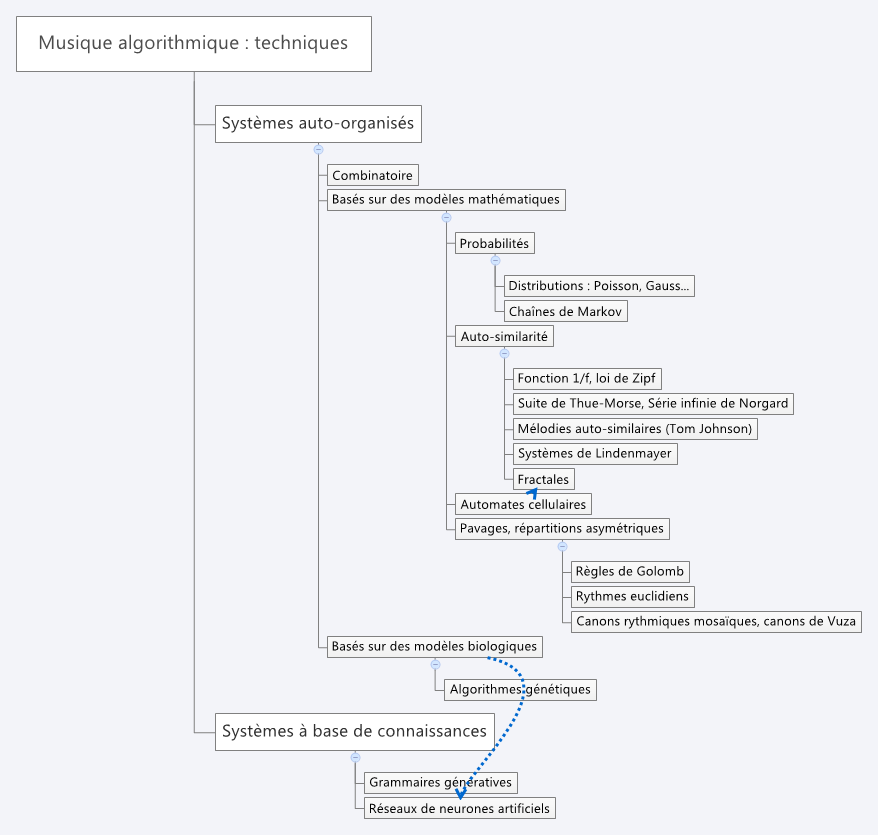

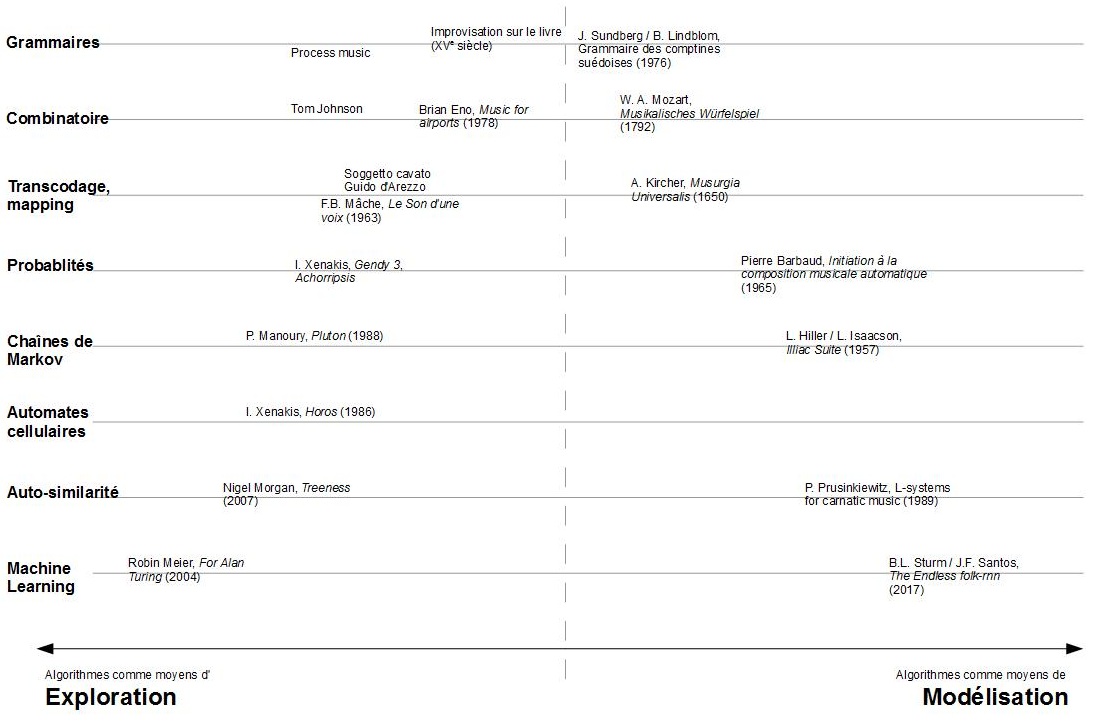

On peut cependant tenter de rassembler les techniques utilisées en composition algorithmique en grandes catégories :

Comme toute taxonomie, il convient de nuancer ce classement arbitraire des outils algorithmiques en deux grandes familles que seraient les systèmes auto-organisés et bases de connaissances. Par exemple, on peut tenter d’organiser non plus les outils mais les créations elles-mêmes, dans une représentation matricielle répartie selon deux axes : dans l’axe de droite (modélisation), les algorithmes sont utilisés pour modéliser un corpus existant, puis inférer de nouvelles pièces. Plus on s’éloigne du centre du schéma sur cet axe, plus l’outil utilisé diffère de la méthode mise en oeuvre par le compositeur (ou l’improvisateur) à l’origine du corpus modélisé. Les grammaires génératives seront donc proches du centre, le machine-learning proche de l’extrémité. Sur l’autre axe (exploration), l’algorithme est utilisé directement, pour lui-même pourrait-on dire, dans le but de créer des formes riches, complexes, nouvelles. Plus on s’éloigne du centre, moins les formes créées sont redevables à des formes préexistantes.

Reste que la musique algorithmique, comme la synthèse du son, est un domaine où il faut généralement combiner plusieurs techniques pour atteindre un résultat digne d’intérêt. Il en va de chacun de ces outils comme des pièces d’un jeu de construction virtuel, dont il appartient au musicien d’explorer les complémentarités selon ses besoins : flux des chaînes de Markov associés au sens de la structure des grammaires génératives, richesse des systèmes probabilistes associée aux contraintes des algorithmes génétiques…

Depuis une dizaine d’années, la recherche dans cette discipline met particulièrement l’accent sur l’intelligence artificielle : raisonnements par cas, concurrency models, et bien sûr les techniques dérivées des algorithmes génétiques et les réseaux de neurones.

Cliquez sur les dés et découvrez une page au hasard