Pouvez-vous nous parler de votre parcours, et notamment de ce qui vous a conduit à vous intéresser à la composition assistée par ordinateur et à la création algorithmique ?

J’ai une double formation. Au Brésil, où j’ai grandi, j’ai fait l’école polytechnique de São Paulo, comme ingénieur chimiste, et ensuite j’ai suivi un cursus de composition et direction d’orchestre. Ce double parcours m’a conduit naturellement à me demander si les deux choses pouvaient être compatibles. Ce n’est pas tant l’informatique qui m’intéressait que la formalisation et les mathématiques. A la même époque, dans les années 70, j’ai lu La Musique, discipline scientifique de Pierre Barbaud et Musiques formelles de Xenakis.

J’ai ensuite fait en France le DEA « Musique et musicologie du XXe siècle », qui associait à l’époque l’Ircam, l’Ecole des Hautes Etudes et l’Université Paris 4, puis la thèse. J’ai alors découvert l’Ircam, et j’y suis resté. Aujourd’hui, je suis RIMCE (Réalisateur en Informatique Musicale Chargé d’Enseignement) et chercheur dans l’équipe Représentations musicales.

L’approche formelle a toujours été mon point de vue sur la musique, ce qui désespérait d’ailleurs un peu mes professeurs… Ça a commencé dès les exercices de contrepoint : je recherchais l’algorithme qui se cachait derrière la règle, et je passais plus de temps à essayer comprendre le mécanisme qu’à faire l’exercice lui-même. Pourtant, au Brésil, j’avais eu une expérience de flûtiste et de chef d’orchestre pendant une dizaine d’années, avec des petits ensembles, et j’avais une relation très pragmatique à la musique. En deuxième année universitaire, en analyse musicale, j’avais apporté à mon professeur une analyse d’une trentaine de mélodies de plain-chant tirées du Liber Usuale, en premier mode (protus), pour lesquelles j’avais réalisé à la main des matrices de Markov. Cela me permettait de montrer les points stables du mode, et au contraire les degrés qui ne sont que des notes de passage… J’avais aussi fait des études statistiques sur Mathis der Maler de Hindemith. Cette manière de penser la musique me suit jusqu’à aujourd’hui.

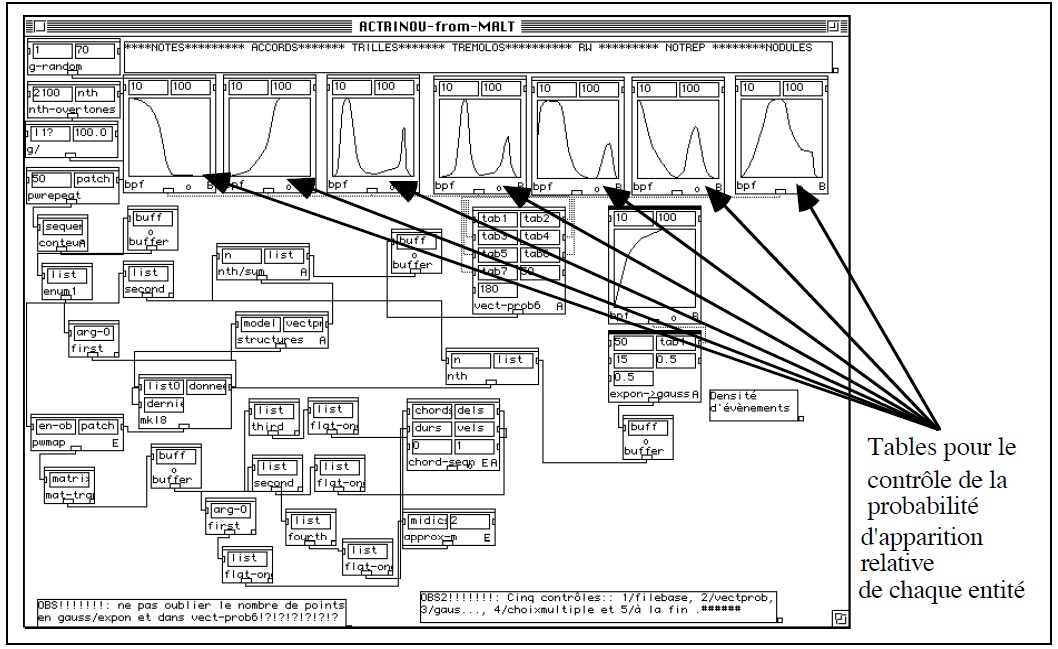

En composition, j’ai rapidement ressenti le besoin d’utiliser un ordinateur. A la fin des années 70, j’avais cassé ma tirelire pour m’offrir le “summum” : un ZX Spectrum, avec 48 K… J’avais composé une longue pièce pour percussions qui m’a pris plus de temps à retranscrire qu’à écrire. Mais la première pièce vraiment formalisée date de mon arrivée en France, lorsque j’ai découvert le monde du Macintosh et suis ainsi passé d’un ordinateur à 48 K à 8 Méga, ce qui était un changement d’échelle considérable. Il s’agissait d’une pièce pour piano seul, Actrinou, entièrement composée dans le logiciel Patchwork.

Dans quelle direction vos pièces ont-elles évolué depuis vos premières créations génératives ?

Je ne parlerais pas de direction mais plutôt de constante. Rétrospectivement, je m’aperçois que ma recherche tourne toujours autour de la notion de systèmes dynamiques, que je décline à chaque fois d’une manière différente. Un système dynamique, c’est une machine pour laquelle on définit plusieurs états et une fonction d’évolution (qui décrit la façon dont on va parcourir ces états, ce qui produit une forme). Les “états” peuvent être une note, un geste musical, ou plus souvent, dans mon cas, une catégorie de gestes, d’identités musicales. L’une des hypothèses de ma thèse était que toute musique pourrait être vue comme un système dynamique en évolution.

Par ailleurs, j’aime savoir en amont comment la pièce va sonner. Dans mon approche, une idée musicale doit toujours préexister, avant la phase de modélisation. Partir d’un modèle et se demander ensuite si le résultat vous convient ou non, ce serait un peu comme se mettre en couple avec quelqu’un avant de s’être demandé s’il vous plaît…

Quelle serait votre création que vous jugeriez la plus aboutie sur ces problématiques ?

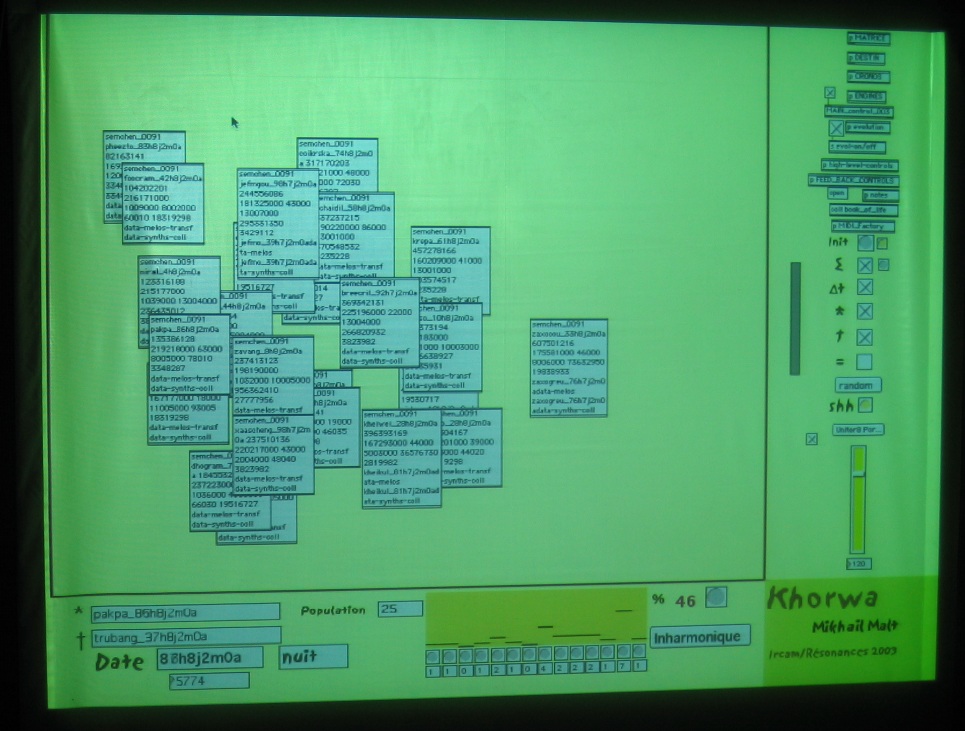

Celle dont je suis sans doute le plus satisfait est une installation présentée à l’Ircam pour le festival Résonances en 2003, Khorwa. J’y avais conçu la musique comme un être vivant, en m’inspirant d’un modèle de vie artificielle, les agents autonomes. Ça m’a pris un an et demi pour construire le programme dans Max4, et plusieurs mois pour le régler, « l’accorder ». Le réglage a été très compliqué : parfois je laissais le patch tourner, et quand je revenais dix minutes après, tous les agents étaient morts, d’autres fois, je m’absentais pour une réunion, et quand je revenais, Max était planté car 600 agents s’étaient créés…

L’installation évoluait pendant deux semaines de manière complètement autonome, et le défi a été de trouver un algorithme qui permettait d’explorer des directions satisfaisantes tout le temps. Simultanément, il y avait une vingtaine ou une trentaine d’agents autonomes spatialisés, utilisant des sons de synthèse FM, de la synthèse vocale, des filtres et une base d’échantillons alimentée par le public qui pouvait parler dans un microphone.

Qu’entendez-vous par agents autonomes ?

Il y a plusieurs manières de les voir. Pour ma part, j’avais utilisé la définition de Michael Wooldridge, dans An Introduction to MultiAgent Systems. On pourrait définir un agent autonome comme un morceau de code capable de vivre tout seul dans un environnement informatique, avec un minimum de règles pour son comportement individuel et son interaction avec son environnement (ce qui est très important, notamment, pour avoir une cohérence harmonique). Chacun d’eux a une « vie », avec un début, un milieu et une fin. Il peut s’accoupler, et sa progéniture hérite d’une partie de son patrimoine génétique, ce qui permet de faire évoluer le système. Il y a aussi des mutations.

Pourrait-on les rapprocher des automates cellulaires ?

Pas vraiment. Les automates cellulaires évoluent dans des matrices de points. Chacun de ces points n’est pas autonome ; il ne réalise aucune action par lui-même. Simplement, en fonction des règles utilisées, certains points sont activés et d’autres éteints.

Des algorithmes génétiques ?

Non plus, car les algorithmes génétiques sont principalement dirigés dans la résolution d’un problème. Mais le processus de recherche pourrait y ressembler. Cependant, dans les algorithmes génétiques, il y a toujours une expression de fitness qui oriente le processus, ce qui n’est pas le cas du tout avec les agents autonomes. Cette absence de direction pré-déterminée est l’une des choses qui m’intéressent, justement.

Dans le patch que j’avais créé, chaque agent autonome contenait plusieurs paramètres : son nom, son genre, mâle ou femelle, l’amplitude de son cercle de vision ou d’audition, et chacun contenait un objet [coll] rempli d’informations, par exemple des courbes d’évolution de modulations de fréquence, la courbe d’évolution de l’enveloppe… Dès qu’un agent naissait, sa durée de vie était déterminée dans le temps, suivant une courbe exponentielle : plus le temps passait, plus la probabilité qu’il décède était grande. Un étudiant à qui je montrais tout ça m’a dit un jour : « Vous n’êtes pas compositeur. Vous êtes méta-compositeur ». C’est une définition que j’accepte volontiers.

Dans le domaine de la vie artificielle, d’autres modèles vous ont-ils intéressé ?

Pas véritablement. Certains processus simples offrent une certaine ressemblance avec la vie artificielle, même des fonctions élémentaires comme les marches aléatoires (random walks) : chaque fois qu’on génère une variable, on prend la valeur antérieure et on additionne ou on soustrait une valeur aléatoire (c’est ce que fait notamment l’objet [drunk] dans Max/MSP), alors qu’un random quelconque est un système amnésique. Les premiers algorithmes dans les années 70 utilisaient des promenades aléatoires pour faire des profils de montagnes. Quand vous appliquez par exemple deux promenades aléatoires aux axes x et y pour déplacer un objet dans l’espace, vous avez l’impression qu’il bouge comme un être vivant.

Actuellement, je m’intéresse beaucoup à la conscience artificielle. Les agents autonomes peuvent être structurées selon différentes « architectures ». Celles qu’on nomme « architectures cognitives » s’inspirent de notre manière de penser : par exemple, elles peuvent être séparées en deux parties, une partie consciente et une partie réflexe. J’ai aussi un peu regardé du côté des réseaux de neurones, mais cela ne me convient pas vraiment…

Vous avez aussi travaillé sur les fractales…

Oui, dans les Réflexions fractales. Il s’agissait plutôt de pièces pédagogiques, commandées par le Conservatoire de Bagnolet. Il devait y avoir 6 pièces pour instrument et bande, et les fractales étaient une manière de donner une structure globale à l’ensemble. Le barycentre des registres des pièces me fournissait une courbe, et cette courbe était déclinée dans chacune des pièces comme une espèce de référence moyenne pour les hauteurs.

Vous êtes un fin connaisseur des aspects génératifs dans la musique de Xenakis, volontiers cité parmi les pionniers sur ces questions. Comment son travail a-t-il nourri votre approche de compositeur ? Comment voyez-vous son héritage sur ces questions, en-dehors de votre musique ?

Pour moi en tout cas, il a été fondamental. Je suis parti de sa formalisation de l’espace musical comme un espace vectoriel, qui était une manière tout-à-fait nouvelle de décomposer l’espace musical, très différente du biais sériel. Ma pièce pour piano Actrinou doit beaucoup à cette approche.

Mais pour Xenakis lui-même, la composition algorithmique n’a été qu’une phase dans son œuvre. Peu à peu, il s’est ensuite éloigné de l’ordinateur, et sa formalisation s’est opérée à un niveau beaucoup plus global. C’est un peu comme s’il avait dialogué avec la machine et qu’elle lui avait enseigné quelque chose, qu’il s’était ensuite pleinement approprié…

La question de l’héritage est complexe. Tout compositeur essaie d’avoir une « étiquette » pour qualifier son travail. Xenakis a appelé sa musique « stochastique », dans un certain besoin de se distinguer. Il est difficile de l’appliquer à d’autres artistes. Reste que beaucoup de compositeurs pensent formellement leur musique de nos jours, de Marco Stroppa à Tristan Murail, dans des buts esthétiques très différents… Je ne crois pas qu’aucun modèle mathématique ou formel ne puisse définir en soi une esthétique. Certes, Tristan Murail fait plutôt de la CAO : quand un résultat ne lui convient pas, il le modifie. Mais il ne faut pas oublier que Xenakis en faisait autant. Tous les analystes ont montré qu’il n’appliquait pas les calculs tels quels. Et lui-même, dans Musiques formelles, va jusqu’à définir un seuil du coefficient de corrélation qu’il juge “acceptable”, entre 0,7 et 0,8, entre les calculs présentés et la partition produite.

L’essor de l’utilisation des audio-descripteurs et des “corpus-based compositions”, va-t-il selon vous faire évoluer l’algorithmique, notamment vers une voie plus “concrète” (au sens schaefferien) que celle qu’on lui connaît jusqu’à présent ?

Au risque de vous surprendre, je pense que nous assistons aujourd’hui à une baisse de l’intérêt pour les musiques algorithmiques au sens strict. Il y a eu un pic au milieu des années 90, et aujourd’hui, l’algorithmique, même si elle ne s’est pas encore asséchée, ressemble plus à une petite rivière… Je le vois en observant les étudiants du cursus Ircam année après année : sur une dizaine de compositeurs, ceux qui réfléchissent vraiment de façon formelle, en-dehors d’une simple curiosité pour ces questions, sont très minoritaires, peut-être un étudiant par an ou tous les deux ans. Les jeunes générations sont avant tout soucieuses de revenir au son, au timbre, ce qui passe beaucoup, depuis 15 ou 20 ans, par les descripteurs audio.

Mais les deux problématiques commencent à se rencontrer, le travail qui a été fait récemment sur les outils d’orchestration automatique, par exemple, est un moyen terme entre les deux choses. Auparavant, l’algorithmique était principalement appliquée à l’écriture symbolique. A l’époque où Schaeffer parlait de la « masse sonore », c’était encore un concept assez abstrait et métaphorique. Maintenant, on peut proposer des définitions de ce qu’est un son avec beaucoup ou peu de masse, et trouver ainsi d’autres manières de classifier les sons, ce qui ouvre de nouvelles possibilité de les manipuler. L’évolution de l’algorithmique se poursuit, mais à un niveau différent. Dans les années 70, Pierre Barbaud consacrait un livre entier à la formalisation de l’échelle des 12 sons, et aujourd’hui on dispose d’outils pour trouver un équivalent orchestral d’un son concret…

C’est une forme de retour en arrière, mais plutôt sur l’axe d’une spirale : on retrouve des problématiques du passé, mais à un niveau supérieur.

Les exemples de cette tendance ne manquent pas. Ainsi, il existe cet environnement de CAO basé sur les descripteurs qui se nomme Audioguide, réalisé par le compositeur américain Ben Hackbarth, où il extrait des rythmes de sons et les applique à d’autres sons.

Outre Ben Hackbarth, je pourrais citer Aaron Einbond, qui a produit une pièce d’après des sons de glaciers utilisant les systèmes d’analyse avec descripteurs pour rechercher des correspondances avec les sons de glaciers dans un corpus de sons instrumentaux. Il y aurait aussi Christopher Trapani, Daniele Ghisi, Frédéric Lebel, qui vont très loin dans l’utilisation de l’algorithmique pour dompter le son…

Quelles sont selon vous les technologies ou les outils conceptuels développés actuellement qui vous semblent porteurs des voies les plus fertiles ?

En ce qui concerne les outils informatiques eux-mêmes, on assiste à une démultiplication folle de l’offre. Parallèlement, les jeunes générations n’hésitent pas à apprendre directement des langages de programmation comme Python ; ils ont conscience que s’ils maîtrisent les concepts, ils peuvent les actualiser dans l’interface de leur choix. Il y a aussi la tendance à aller vers des environnements moins fermés que les Mac et les Pc.

Du côté des modèles, outre les agents autonomes, je pense évidemment que les modèles d’intelligence artificielle sont une voie très prometteuse. En ce moment, je co-dirige la thèse de Jean-François Ducher, qui travaille sur intelligence artificielle et modèles d’improvisation. Mais pour le moment, la phase d’apprentissage en machine learning prend beaucoup de temps, et ne peut se faire avec un petit ordinateur. Tous les compositeurs n’ont pas à leur disposition un chercheur et un rack de serveurs à 200 000 €…

Les modèles de réseaux de neurones sont très fermés. Les modèles de vie artificielle peuvent diverger et nous étonner plus facilement, mais les réseaux de neurones sont avant tout programmés pour reproduire ce qu’ils ont appris.

Il y a aussi le problème de leur opacité : dans les chaînes de Markov, la matrice peut être récupérée, et nous enseigner des choses. De ce point de vue, les algorithmes de machine learning peuvent être plus intéressants que des réseaux de neurones pour les compositeurs, car on peut regarder les représentations internes qui sont générées, avoir la main dessus, les modifier. Je peux interpoler deux matrices de Markov, par exemple. Avec les réseaux de neurones, personne ne sait vraiment ce qui se passe à l’intérieur.

Mais on est au tout début, cela va sans doute nous étonner.

Dans l’histoire (ou la préhistoire) de l’art génératif, de quel musicien ou de quel artiste vous sentiriez-vous le plus proche ? D’une manière plus générale, quels artistes, écrivains ou musiciens ont eu une importance décisive sur votre travail ?

J’adore tous les constructivistes russes, et les abstraits des années 50 – 60, l’art cinétique, Vasarely… On n’a pas retrouvé une telle énergie en terme de génératif, je crois…

Mais il ne faut pas négliger une chose, c’est la grande difficulté de l’art génératif, qui nécessite beaucoup de travail et de patience, parfois pour pas grand chose. C’est souvent bien plus simple de faire les choses à la main, ce qui nous ramène à ce que me disaient mes professeurs pendant mes études… Jean-Claude Risset disait que la musique met en branle une multitude de modèles différents, les espaces, les hauteurs, les durées, les timbres… Idéalement, il faudrait pouvoir formaliser toutes ces dimensions.

Les jeunes compositeurs dont je vous ai parlé sont une grande source d’inspiration pour moi. Je trouve leur travail remarquable. Je suis professeur mais j’apprends beaucoup de mes élèves, de leur esthétique, de leur point de vue musical.

Quels sont vos projets actuels ? Font-ils écho à ces problématiques ?

J’envisage de ressusciter l’installation Khorwa sous une forme différente, probablement de manière robotique, mais ce n’est encore qu’un projet. Les agents autonomes vont venir dans notre monde… Mais s’il y a quelque chose que j’ai appris au contact d’autres compositeurs, c’est qu’il ne faut jamais trop parler des projets en cours. J’en ai déjà trop dit !

(Propos recueillis en mars 2019)