Peux-tu nous parler de ton parcours, et notamment de ce qui t’a conduit à t’intéresser à l’informatique musicale et à l’art génératif ?

Ma formation est plutôt traditionnelle. J’ai fait des études de piano, de composition et de musique électroacoustique, très marquée par la pensée du GRM. Par ailleurs, j’ai un parcours plus autodidacte dans le rock et l’improvisation. Je n’ai pas eu de véritable formation scientifique, même si j’ai toujours été très curieux des mathématiques et que j’appartiens à une génération qui a été exposée très jeune à l’informatique.

C’est l’un de mes enseignants de composition, Paolo Aralla, qui m’a fait découvrir Patchwork et Max/MSP. Grâce à lui, j’ai commencé à intégrer des systèmes plus formels dans mes composition, notamment les techniques spectrales, jusqu’à me bricoler avec des programmes simples, parfois même avec Excel, des calculateurs de fréquences et d’index de fréquences, avant d’utiliser Patchwork et OpenMusic.

J’ai étudié à l’Ircam assez tardivement, à plus de 30 ans. J’y suis entré avec l’intention d’étudier le son électronique, et j’en suis sorti en voulant travailler sur la formalisation.

J’avais déjà rencontré Daniele Ghisi, un ou deux auparavant, mais ça a été lors de notre première année à l’IRCAM que nous nous sommes aperçus que certaines thématiques nous passionnaient tous les deux. Au début, nous avons parlé, presque comme une blague, d’inventer notre propre système de composition assistée par ordinateur, pour résoudre les limites que nous voyions aux systèmes existants à l’époque. C’est de là qu’est née la librairie BACH. L’outil se veut aussi généraliste que possible, même si aucun système n’est neutre. Mais nous voulions éviter cette tendance de certaines librairies d’Open Music, au demeurant précieuses, à être très orientées par la poétique des compositeurs qui les ont développées (Murail, Stroppa…). Nous voulions un système plus « agnostique »…

Y a-t-il dans ton catalogue une œuvre qui marque le début de ton intérêt pour les questions de formalisation ?

Les choses se sont plutôt faites de manière progressive. J’ai essayé de m’y intéresser de plus près pendant mes années à l’Ircam, mais je ne me considère pas pour autant comme un compositeur dédié entièrement à la question de la musique algorithmique, comme on pourrait le dire de Mauro Lanza, par exemple. Mon imagination compositionnelle est plus traditionnelle… Je confie certains paramètres à des processus algorithmiques, mais ils sont toujours confrontés à des moments où je transcris plus directement ce que j’imagine.

Mes pièces qui poussent le plus loin ces techniques sont souvent des pièces plus courtes, comme des études. Ce sont aussi souvent des objets musicaux assez simples, des machines assez dépouillées.

Il y a par exemple le deuxième mouvement d’une pièce pour piano, flûte et saxophone et électronique, Two songs, a room, 23 ephemeral illuminations, not all distinct, qui présente au piano un catalogue exhaustif d’arpèges avec certaines caractéristiques intervalliques, par-dessus lesquels un processus automatique génère des sons de synthèse. Mais s’ajoutent des parties de flûte et saxophones écrites plus librement, en fonction de certains accidents qui apparaissaient dans la partie de piano.

Dans 3-minute song #1 (2016), pour 5 instruments, on peut retrouver un processus similaire, avec un catalogue d’échelles, qui génère une harmonie différente à chaque note, comme un choral très long et très rapide. Le travail d’instrumentation est là encore plus libre, tenant compte des registres de chaque instrument, de la respiration du clarinettiste, des mouvements de l’archet…

Qu’est-ce qui t’a conduit à t’intéresser à l’algorithmique ?

D’une certaine manière, on pourrait dire qu’il n’existe aucune musique qui ne soit pas formalisée, au moins de manière élémentaire. C’est parfois seulement l’emploi d’une mesure en 4/4, une structure formelle basées sur des puissances de 2, comme dans n’importe quelle chanson pop…

Bien souvent, mon imagination musicale se rapporte à des situations ponctuelles, méta-temporelles, des points dans le temps. Mais la musique ne prend sens que si elle se déroule dans le temps. Et je ne suis bien sûr pas le seul dans cette situation : c’est un peu le principal problème de la composition. Les solutions varient selon les époques et les contextes culturels. Par exemple, dans une très grande majorité des musiques produites dans le monde, le moteur de l’articulation temporelle est la parole, ou alors le mouvement physique, la danse. La parole est un moteur formel d’une incroyable puissance. D’une certaine manière, un peu sublimée, on en retrouve la trace dans la grande tradition romantique, chez Schumann par exemple ; c’est ce qu’on pourrait presque appeler une « sonification » émotionnelle (en employant « sonification » dans un sens très large…). Même dans les pièces plus abstraites de cette époque-là, la raison ultime est toujours sémantique ; il y a toujours un contexte extra-musical, de plus en plus intime et subjectif au cours du XIXe, qui guide l’articulation des contenus dans le temps. Et on en arrive presque à définir une sorte de grammaire et de dictionnaire de relations entre des états intérieurs et des mécanismes mélodiques, rythmiques et surtout harmoniques. Une partie de l’activité de composition était donc de traduire, de transduire en musique une structure dramaturgique et temporelle préalable, extra-musicale. Ce qui dans le cas de certaines « musiques à programme » arrive presque au ridicule… Et la musique de film hollywoodienne est la conséquence ultime de ce type d’approche.

Si l’on recherche ce qui nous reste aujourd’hui pour articuler le temps musical, l’une des solutions les plus intéressantes est le processus.

Utilises-tu ces techniques plutôt dans un contexte de notation symbolique ou électroacoustique ?

Si l’on regarde la partition de cette pièce assez récente qu’est 3-minute song #1, on voit qu’il y a très peu d’articulations, presque pas d’indications de dynamiques. Mon idéal d’écriture y semble plus proche de Bach que de Lachenmann.

À une époque de l’histoire de la musique, la dimension représentationnelle n’a plus été suffisante pour soutenir le poids de l’activité compositionnelle. Il s’est produit une réaction historique, conduisant à évacuer de la musique toute dimension référentielle, ce qui est un peu l’histoire implicite du sérialisme, et plus explicitement l’histoire de musiques plus récentes, à partir du spectralisme jusqu’à certains compositeurs des années 80 ou 90, comme Marco Stroppa (que j’admire infiniment). Je parlerais alors volontiers de musique autoréférentielle, si le terme n’était pas péjoratif.

En m’interrogeant sur la perte de la relation de la musique contemporaine avec le public, je me demande si ce n’est pas là le moment marquant. Car la fracture date plutôt des années 80. Bien sûr, dans les années 60 ou 70, la musique contemporaine s’adressait déjà un public de niche, mais c’était aussi le public de l’art contemporain, du cinéma d’avant-garde, de la littérature expérimentale… À partir des années 80, la musique contemporaine n’a pas seulement perdu son public, mais aussi son lien avec le milieu culturel. Tout écrivain averti des années 60 connaissait la musique de Stockhausen ou de Boulez, tandis qu’aujourd’hui très peu d’écrivains culturellement avertis connaissent la musique de Philippe Manoury ou de Marco Stroppa. La raison est peut-être à chercher du côté de cette perte de référentialité, qui était nécessaire historiquement mais pose beaucoup de problèmes pour le futur, à cause de l’éloignement d’un contexte de réflexion culturelle plus général. C’est la raison pour laquelle je cherche à récupérer une certaine forme de référentialité, pour que la musique ne parle pas que d’elle-même.

Pour cette raison, je tiens beaucoup à travailler au niveau symbolique, davantage peut-être qu’au niveau littéral sur le son. Même si je travaille avec des sons, ce que je veux partager n’est pas de l’ordre du son mais du sens. Je ne pense pas que, face au timbre en tant que tel, l’auditeur ait une finesse représentationnelle suffisante pour construire une grammaire. Je crois que, d’un point de vue simplement perceptif, notre potentiel d’organisation du timbre n’est pas suffisant pour créer des espaces de paramètres assez structurés et assez fins pour soutenir une grammaire. C’est pourquoi je me tourne, pour l’instant, vers d’autres espaces de paramètres, que je trouve du côté de la note.

Je ne dirais pas pour autant que l’on peut traduire une musique en une autre musique, même si c’est une idée qui me fascine. Dans Gödel, Escher, Bach, Douglas Hofstadter écrit que, d’un certain point de vue, la meilleure traduction anglaise de Dostoïevski, c’est Dickens. Bien sûr, la musique n’est pas un langage au sens littéral, elle n’appartient pas à un contexte linguistique. Mais on peut se demander s’il existe des niveaux où cette idée de traduction peut avoir du sens.

Comment vois-tu la relation entre l’écriture algorithmique et l’acousmatique ?

Après avoir créé beaucoup de musique acousmatique, je m’y suis senti très limité. Mon passage à l’Ircam a été un tournant sur ce point. J’ai ressenti alors le besoin de gagner un certain contrôle sur le son électronique, qui ne pouvait plus passer pour moi par la recherche et la transformation de sons enregistrés. J’ai donc commencé à faire de la synthèse additive, qui est probablement la plus formalisable des techniques de synthèse, et cela a duré plus de dix ans, comme un long sacerdoce pour retrouver un rapport plus profond entre la représentation symbolique propre aux formalismes et le son électronique.

…on peut faire de la synthèse additive pendant dix ans sans s’ennuyer ?

Mais je m’ennuyais beaucoup ! Je dis souvent à mes étudiants « Ce n’est pas mon problème si tu ne t’amuses pas, ce qui compte c’est que moi je m’amuse en écoutant ta pièce ! »…

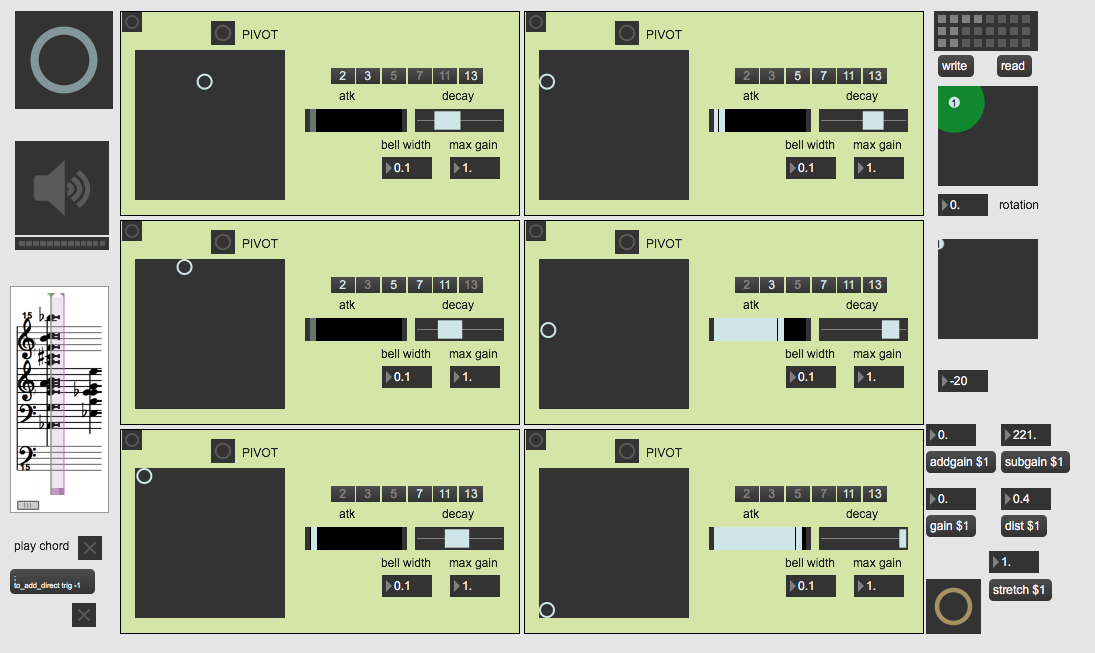

Initialement, je définissais dans Max/MSP des structures harmoniques, souvent issues de dérivations spectrales, puis, de façon assez empirique, je me suis constitué une sorte de solfège de la synthèse additive, que je ne suis jamais arrivé à automatiser…

La première pièce composée ainsi fut Legno sabbia vetro cenere, pour quatuor à cordes et électronique, conçu à l’Ircam en 2009, qui est encore aujourd’hui l’une des pièces dont je suis le plus satisfait. Il s’agissait pour moi d’augmenter le quatuor en développant le même matériau harmonique et articulatoire dans la partie électronique. Je pensais alors au Quintette de Schumann pour cordes et piano ; l’électronique était un peu mon piano, au comportement acoustique complètement distinct du quatuor, mais qui partage avec lui un même matériau.

Je commençais par écrire dans Finale des expressions textuelles, que j’exportais en xml vers Max/MSP, qui gérait le moteur de synthèse, puis convertissais dans Antescofo qui gérait les paramètres dans Max.

Selon toi, qu’est-ce que le machine learning peut apporter à la composition musicale ?

C’est une chose à laquelle je suis obligé de m’intéresser en tant qu’enseignant en informatique musicale. Le machine learning a principalement deux facettes dans ses applications pratiques : des mécanismes de classification et d’évaluation, et des mécanismes génératifs basés sur l’apprentissage d’exemples. L’intérêt industriel du premier aspect est évident pour des services de streaming, par exemple. Mais on pourrait aussi citer la recherche sur les environnements sonores, qui doit traiter de très longs fichiers, et où ces techniques peuvent s’avérer précieuses pour identifier rapidement des caractéristiques ou des parties particulièrement significatives.

Du côté des compositeurs, l’intérêt reste encore un peu utopique. Mais il existe d’ores et déjà, en particulier dans un contexte acousmatique, des moyens « intelligents » de rechercher dans de très grandes bases de données sonores. C’est ce que fait entre autres Mubu pour Max/MSP, en générant des analyses par audio-descripteurs afin de permettre des recherches dans des bases d’après des critères de similarités.

D’une manière générale, l’apprentissage machine s’oppose aux systèmes « déclaratifs » (par exemple de programmation par contraintes). Les systèmes déclaratifs semblent moins souples et moins puissants que ceux basés sur l’apprentissage, mais ont un avantage majeur dans un contexte artistique : la possibilité de spécifier de manière explicite les caractéristiques de l’objet que l’on souhaite produire. Alors que dans les systèmes par apprentissage, je ne peux produire un objet, d’une certaine manière, que si je dispose déjà d’un objet similaire.

Il est bien possible que l’apprentissage humain de la musique passe par un système pas si différent de celui modélisé par le machine learning. Cela ouvre la perspective utopique (ou dystopique) d’artistes non humains, d’artistes « silicon-based ». Ce qui m’éloigne sans doute un peu de ces approches, c’est que je m’intéresse davantage aux œuvres qu’aux artistes…

Reste qu’un compositeur humain n’apprend pas seulement à composer en écoutant de la musique : sa façon de vivre tout le reste de sa vie, sa manière de s’alimenter, de marcher, de désirer, etc. constituent une dimensionnalité additionnelle énorme, infiniment supérieure à ce que produit simplement l’écoute de musiques similaires.

Imaginons qu’un projet de collaboration avec une équipe d’ingénieurs dans le domaine du machine learning te soit proposé. Qu’en ferais-tu ?

Je serais très curieux d’appliquer l’apprentissage machine, non pas seulement à la synthèse, mais au contrôle de la synthèse. Je ne suis pas tellement intéressé par l’idée de générer de manière opaque des chaînes d’échantillons produisant un son. Mais je vois un immense potentiel du côté de certaines techniques de synthèse, notamment la synthèse additive, qui est un paradigme extrêmement puissant mais qui nécessite la maîtrise d’un très grand nombre de paramètres. Il est possible que le machine learning puisse aider à réduire cette énorme dimensionnalité à un sous-ensemble beaucoup plus petit et exploitable, cognitivement manipulable. Une sorte de couche intermédiaire, de banque de paramètres de synthèse, permettant au compositeur d’intervenir. Je rêve d’un système « intelligent » (avec beaucoup de guillemets) qui me laisse du contrôle.

Quels seraient les compositeurs, artistes, écrivains, qui ont eu un impact décisif sur ton travail ? Ont-ils un rapport avec la création générative ?

D’une manière générale, je me considère comme quelqu’un de très perméable… Il m’est donc difficile de répondre car tout m’influence.

Bien sûr, je pourrais citer en premier lieu Gérard Grisey, particulièrement celui de Vortex Temporum et des Quatre chants pour franchir le seuil. Il a découvert des choses que personnes n’avait imaginées sauf peut-être Stockhausen, autre immense visionnaire de la musique d’après-guerre. Il y aurait aussi Fausto Romitelli, pour sa manière de mettre en relation les musiques « non-savantes » avec les techniques spectrales. J’ai eu la chance de le rencontrer en étant bassiste dans une exécution de Professor Bad Trip, et je me souviens d’une longue discussion avec lui sur la noise japonaise, ABBA, Grisey… Mais ces questions de saturation, de son brutal, qui sont ensuite devenues un peu à la mode, ne sont pas ce qui m’intéresse le plus chez lui. Sa pensée était fortement harmonique, mélodique même, avec une recontextualisation de gestes parfois très connotés, et la création de nouvelles fonctionnalités harmoniques, qu’on retrouve déjà dans Domeniche alla periferia dell’impero, qui est un peu la répétition générale avant Professor Bad Trip. C’est – presque – une pièce en ut mineur, et très représentative de cette recherche d’une liaison entre l’harmonie des musiques populaires et la consonance du spectralisme.

De manière plus personnelle, j’ai aussi été très marqué par Paolo Aralla, et par Yan Maresz, qui est un peu le compositeur que j’aurais voulu être, pour sa musicalité, son attention à l’écoute, son usage de la technologie…

Plus indirectement, je citerais Jimi Hendrix, Led Zeppelin et beaucoup d’autres… le rock guide certains aspects profonds de mon travail de composition, quoique aujourd’hui je sois plus intéressé par d’autres expériences dans les musiques populaires, notamment dans le domaine de la black music.

En littérature, il y aurait Italo Calvino et Raymond Queneau, pour l’aspect combinatoire, mais je n’ai jamais été capable d’établir de véritables relations entre formes littéraires et musicales. Comme j’ai déjà dit, tout ce que je lis et vois m’influence, ce qui reviendrait à énumérer tous les livres, les films, les tableaux que j’ai le plus aimés… Je pourrais citer au moins Roberto Bolaño, découvert il y a quelques années. Sa manière d’articuler la narration m’a frappé immensément… Et puis, je ne peux pas oublier et Gödel, Escher, Bach de Douglas Hofstadter, que j’ai lu pour la première fois dans mon adolescence et qui a marqué de façon définitive ma vision de la relation entre l’art et la pensée rationnelle.

Peux-tu nous parler de tes projets ? Ont-ils un lien avec des techniques algorithmiques ?

Côté recherche, le travail autour de BACH se poursuit dans deux directions : les implications esthétiques du développement informatique (en lien avec le musicologue et compositeur, Eric Maestri) et une réflexion plus technique sur les paradigmes de composition pour la computer music, les avantages et désavantages des différentes manières d’exprimer un processus dans un langage de programmation donné (en lien avec un informaticien de l’Ircam, Jean-Louis Giavitto). Max/MSP et Open Music, malgré une surface graphique très similaire, fonctionnent sur des principes de programmations parfois presque opposés. Max/MSP sert à construire des instruments de musique, Open Music sert à représenter des formules mathématiques. Cela a de fortes implications sur la manière de programmer.

Du côté de la création musicale, il y a le projet d’une pièce d’une heure pour quatuor de percussions et piano avec électronique. Je voudrais pour la première fois depuis douze ans faire une pièce avec électronique temps réel, et intégrer une écriture algorithmique du temps réel.

(Propos recueillis en avril 2020)