Peux-tu décrire comment ton parcours t’a conduit à t’intéresser à la composition assistée par ordinateur et à l’algorithmique ?

J’ai commencé à étudier la composition, ou plus précisément l’écriture, au Conservatoire de Venise, et c’est d’ailleurs un cursus que je n’ai pas fini, mon seul prix au Conservatoire étant un prix de piano. J’avais une pratique plus personnelle de la composition en parallèle, et j’essayais, de manière très naturelle, de trouver des systèmes, qui étaient souvent des outils proches de la combinatoire. Il s’agissait plutôt de systèmes déterministes, avec peu d’aléatoire, que je faisais à la main, et je me suis rendu compte que j’aurais pu faire ça plus vite et mieux avec l’aide d’un ordinateur. Peu après avoir passé l’examen de contrepoint et fugue, je suis parti travailler à l’Ircam.

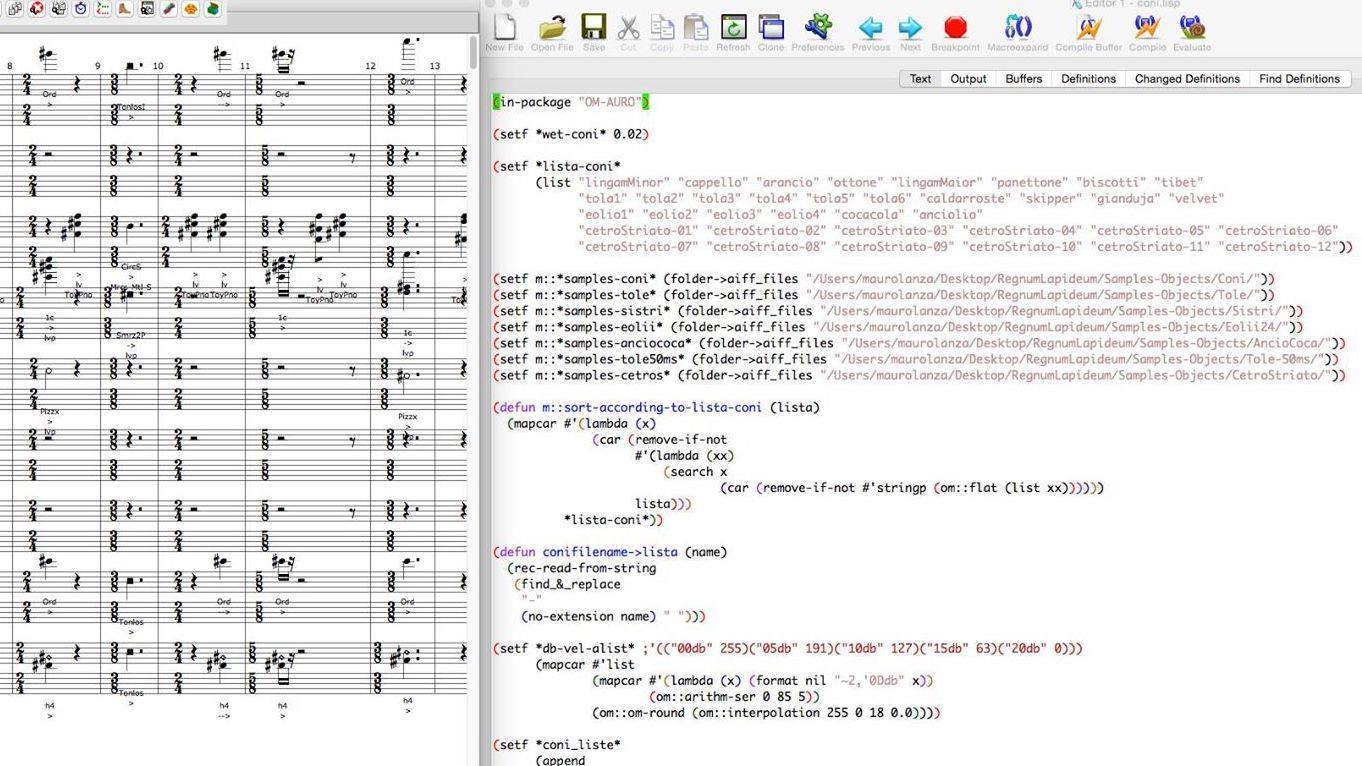

J’avais entendu parler des amis compositeurs d’un logiciel d’aide algorithmique à la composition (PatchWork) qui se développait à l’Ircam, et j’avais immédiatement commencé à fantasmer à ce sujet. C’est l’une des principales raisons qui m’ont poussé à postuler au cursus de l’Ircam – formation davantage consacrée à la synthèse et au traitement sonore, mais dont la partie qui m’intéressait le plus était celle qui concernait la composition (symbolique) assistée par ordinateur – et la raison pour laquelle, dès le début de mon cursus, j’ai commencé à travailler à la fois sur l’environnement graphique de CAO développé par l’Ircam (OpenMusic, le temps de PatchWork étant révolu) et en langage Lisp.

Finalement, je préfère aujourd’hui taper du code que de faire des patches (même si j’en fais toujours, mais à des phases différentes du travail). Nommer des variables est plus facile que tirer des spaghettis… Lorsqu’on a un travail complexe à accomplir, même du point de vue conceptuel, je pense qu’il est préférable de le programmer en texte, car on fait forcément les choses plus proprement. Je me sers toujours de l’environnement graphique, pour faire des choses quick and dirty, à la fin d’un processus, en connectant des fonctions très complexes pré-programmées en langage textuel. La programmation continue à prendre beaucoup de place dans mon travail, et il m’arrive d’arrêter de composer (même pendant plusieurs mois) pour me consacrer entièrement à la programmation.

A l’Ircam, il y a aussi tout un autre univers qui s’est ouvert à moi, qui était celui du contrôle de la synthèse. D’autres le faisaient déjà avant moi, notamment Marco Stroppa avec sa librairie Chroma. Je découvrais ainsi que les mêmes outils qui me servaient pour la composition assistée par ordinateur pouvaient aussi contrôler des paramètres sonores.

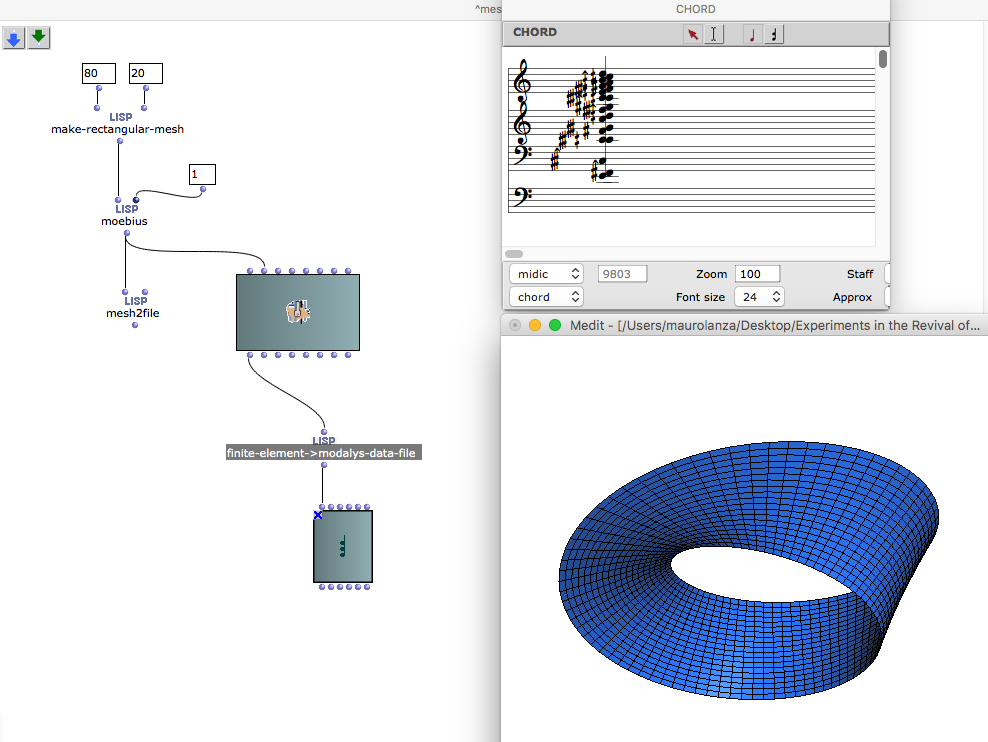

Mes librairies m’aidaient donc à écrire du texte qui était ensuite envoyé à des moteurs tels que Modalys (logiciel de synthèse par modèles physiques que j’ai beaucoup utilisé pendant mes premières années ircamiennes) ou ensuite Csound, dont je me sers toujours (le plus souvent avec des bases de données d’échantillons).

Je me sers beaucoup de Csound pour simuler le résultat d’une composition, notamment depuis le début de ma collaboration avec Andrea Valle. Lorsque nous avons commencé à travailler ensemble sur Regnum Animale pour trio à cordes (notre première œuvre collaborative) le problème de l’échange des données s’est tout de suite imposé. Échanger des partitions n’était pas forcément significatif pour lui, d’autant qu’il n’utilisait pas les mêmes logiciels que moi, donc nous avons décidé d’échanger du son et des scores textuelles, écrites un peu comme les partitions Csound. Par ailleurs, dans Regnum animale, deux cordes sur quatre de chaque instrument sont préparées, et les doigtées de ces cordes ne correspondent pas aux hauteurs perçues (d’ailleurs on ne peut même pas vraiment parler de hauteur, car la préparation rend le son de la corde inharmonique). La partition devient ainsi une sorte de tablature, dont le résultat sonore est très difficile à imaginer, même pour un musicien pourvu d’une excellente oreille : il nous fallait donc une base de données de différents échantillons de cordes, bien classés et analysés, afin de pouvoir tester rapidement le résultat sonore d’un passage et même d’une pièce entière.

Cette base de données peut aussi devenir l’espace de recherche pour des moteur qui, à partir d’une cible (un accord, une analyse spectrale, une séquence…) peuvent trouver le « candidat idéal » (par exemple la séquence de pizzicatos sur des cordes préparées qui se rapproche le plus d’une mélodie donnée).

Il y avait aussi les objets sonores à simuler (Systema naturae, le cycle que j’ai composé avec Andrea Valle, allie aux instruments « classiques » toute une panoplie d’objets électro-mécaniques contrôlés par ordinateur) : ils étaient chez Andrea, posés sur le sol, si nombreux qu’il n’arrivait plus à marcher chez lui, et il était obligé d’enregistrer chaque séquence que je créais afin que je puisse avoir une idée du rendu sonore. Là encore, une séance d’enregistrement objet par objet a été nécessaire, avec bien sûr les limites liées à l’échantillonnage des nuances, qui m’obligeaient à travailler un matériau plus discret que continu. Cette technique permettait de générer facilement des maquettes sonores de Regnum animale, puis de Regnum Vegetabile, avec ses 30 sèche-cheveux qui soufflent dans des tuyaux et d’autres résonateurs.

Dans Ludus de Morte Regis, j’utilise Csound pour générer de la matière sonore, pour faire un peu de synthèse aussi parfois, de la synthèse additive mais surtout une sorte de synthèse concaténative (quoique avec des grains assez gros, le point de départ étant plutôt Diphone que CataRT).

Tu parlais de l’utilisation des techniques algorithmiques appliquées au contrôle de la synthèse. Aurais-tu des exemples à donner ?

L’utilisation du même environnement permet d’appliquer le même formalisme pour la partie instrumentale et pour la partie électronique. Même dans une pièce pour électronique seule, cela permet d’avoir une forme de représentation à haut niveau qui se rapproche d’une partition. Finalement, je travaille toujours avec des partitions, même quand je compose pour électronique seule. Dans ces cas-là, les rythmes peuvent être parfois très complexes, mais toujours notables. Ces partitions contrôlent ensuite différents moteurs de synthèse. J’ai très peu recours aux outils classiques de la musique électroacoustique comme les séquenceurs. J’ai installé il y a quelques mois un séquenceur, qui permet un approche un peu plus quick and dirty, mais j’ai toujours travaillé différemment.

Quelles sont les techniques algorithmiques que tu utilises le plus ?

L’une des premières techniques que j’ai utilisées était le “slicing”, où je manipule des listes ou des fragments de musique pour les croiser entre elles. Par exemple, je choisis une séquence, je la découpe en morceaux de longueur décroissante, j’en prends une autre, que je découpe en morceaux de longueur croissante, et ensuite je croise les deux séquences. C’est une sorte de crossfade discret, que j’ai beaucoup utilisé, même dans des pièces très anciennes, comme L’allegro chirurgo pour saxophone, qui était entièrement écrite à la main, sans ordinateur.

Par la suite, j’ai développé des techniques plus complexes. En suivant les cours de Mikhail Malt à l’Ircam, je me suis penché sur d’autres techniques plus conventionnelles dans la musique algorithmique, mais cet intérêt est en fait assez tardif. Dans mes pièces de ces dernières années, à partir de 2010, j’ai ainsi eu recours aux chaînes de Markov (surtout pour les pièces de musique électronique, comme la musique pour le film Häxan), aux systèmes de Lindenmayer (dans certaines pièces de Systema naturae), aux canons de Vuza (Descrizione del Diluvio), plus récemment aux automates cellulaires (John Conway in the Gondola)…

Mais mes premières pièces, et la plupart de mes pièces en général, utilisent des algorithmes que j’ai développés moi-même, qui ne sont pas des formalismes “classés”. Les systèmes par contraintes, le backtracking, sont des techniques que j’utilise tout le temps. J’ai notamment développé un système par contraintes qui génère des patterns rythmiques complémentaires, pour produire des polyrythmies de la plus grande complémentarité possible, et qui fait un peu pendant aux canons de Vuza.

Dans mes premiers mois à l’Ircam, je me suis demandé ce que je pouvais faire avec l’ordinateur que je n’aurais pas pu faire à la main. Pour ma pièce pour voix et électronique Erba nera che cresci segno nero tu vivi, j’ai développé une technique de polyrythmies auto-engendrées par un arbre rythmique à haut niveau. Je partais de ce que j’appelle un rythme à haut niveau, qui génère une polyrythmies avec une série de voix qui suivent des boucles rythmiques de longueurs différentes. Toutes ces boucles partagent certains impacts qui soulignent ce pattern à haut niveau. Ça s’entend beaucoup dans ma pièce pour voix et électronique car l’électronique est très stratifiée, avec parfois 9 ou 10 couches d’instruments. J’ai ensuite étendu le principe à la mélodie elle-même, générant ainsi des voix secondaires automatiques, qui soulignent une grande mélodie étirée dans le temps.

Cette technique provient de l’intérêt que j’avais à l’époque pour l’ethnomusicologie. J’avais suivi des cours à l’Université de Venise, où un séminaire s’était tenu sur le concept de polyphonie, avec des personnalités comme Simha Arom. Il y avait eu notamment une discussion sur la différence entre polyphonie et hétérophonie. Simha Arom avait proposé en préambule que l’hétérophonie relevait de pratiques quasi improvisées, mais le séminaire avait mis en évidence des formes d’hétérophonie tellement complexes qu’elles relèvent de l’écriture. Ma source d’inspiration était la grande famille des hétérophonies du Sud-Est asiatique. Modéliser une forme musicale existante ne m’intéressait pas, mais je désirais faire quelque chose qui se rapproche de cette couleur. Cette hétérophonie mélodico-rythmique est un principe que j’utilise toujours. Même dans Systema Naturae, il y a par-ci par-là des choses générées de cette manière.

Ce jeu d’ambiguïté entre mélodie et polyphonie, est-ce aussi la source de ton intérêt pour les canons de Vuza ?

Au départ oui, c’est bien cette dimension qui m’a attiré vers les canons de Vuza, cette capacité de faire à la fois quelque chose de mélodique et de produire l’illusion d’un contrepoint par le pavage. Mais je ne m’en suis pas vraiment servi de cette façon-là, car pour moi, les canons de Vuza ont un problème assez évident : leur période est beaucoup trop longue, ce qui les rend peu perceptibles pour l’auditeur en tant que canons. C’est un problème pour mon genre d’écriture, qui poursuit – malgré les apparences ! – une certaine simplicité. J’ai utilisé les canons de Vuza dans deux pièces, Descrizione del Diluvio et Ludus de Morte Regis, dans la 2e partie, où je superpose deux canons de Vuza, ce qui peut sembler un peu absurde vu ce que j’ai dit précédemment… Mais j’ai trouvé un moyen de simplifier les canons de Vuza tout en les respectant entièrement. En regardant la structure numérique d’un canon de Vuza, on peut le décomposer en micro-périodes. Si on souligne ces micro-périodes par le même dessin mélodique, cela devient beaucoup plus perceptible à l’oreille, car cela produit un faux canon, qui se répète plus fréquemment. Et les deux canons de Vuza à 14 voix que j’ai choisis pour les superposer se décomposent en micro-périodes qui se ressemblent beaucoup.

Moreno Andreatta m’avait également montré une manière de calculer des canons rythmiques à pavages simples, à partir d’une période et d’un nombre de voix donnés, mais sans les asymétries propres aux canons de Vuza. Je m’en suis servi à plusieurs reprises. On les retrouve à la fois à la fin de Ludus de morte Regis, pour un canon de timbres avec différents “click sounds”, des claquements de langue, bruits de bouches (ces sonorités très utilisées dans les langues sud africaines comme les langues bantoues), et aussi à la fin de ma pièce pour violoncelle et piano (ou violoncelle et électronique), La Bataille de Caresme et de Charnage, où le violoncelle fait un canon à 3 voix et trois timbres différents (col legno, harmoniques col legno, pizz), puis 4, 5, 6 voix.

Tu parlais de ton utilisation des systèmes par contraintes. Aurais-tu d’autres exemples à donner ?

Je m’en sers surtout comme outil algorithmique à bas niveau, pour trouver des solutions, de façon heuristique. J’utilise une librairie qui s’appelle OMCS, OM Constraints, qui a été développée par Mikael Laurson, et qui permet d’ordonner des espaces de recherche avec un poids, avec des contraintes locales. Je m’en sers pour trouver des solutions pas à pas.

Par exemple, lorsque je travaillais sur Regnum animale ou d’autres pièces du cycle, j’avais un espace de recherche qui correspondait aux positions de l’instrument pour produire des notes. En donnant une chaîne d’accords, le système est en mesure de trouver les meilleurs candidats pour créer une monodie ou même une séquence d’accords à deux ou trois notes. Les solutions proposées par le système prennent en compte les accords choisis mais aussi la faisabilité instrumentale, par exemple le “finger span”, la distance entre les doigts, et des contraintes locales, par exemple de ne jamais dépasser l’écartement des doigts au sein d’un enchaînement de 4 notes minimum, ou l’interdiction de faire des sauts de cordes dans les legatos, etc. Cela permet de générer des séquences assez virtuoses qui respectent les contraintes de l’instrument.

Quel intérêt ont pour toi les techniques algorithmiques ?

Je cite toujours cette très belle phrase de Gérard Grisey, tirée de son texte Tempus ex machina : « La composition par processus sort du geste quotidien et par cela même nous effraie. Elle est inhumaine, cosmique et provoque la fascination du Sacré et de l’Inconnu, rejoignant ce que Gilles Deleuze définit comme la splendeur du ON : un mode d’individuations impersonnelles et de singularités préindividuelles. » Cette phrase résume pour moi tout l’intérêt de ces techniques. Je me souviens, même si c’est anecdotique, avoir entendu un jeune compositeur, lors d’un débat après un concert organisé par le groupe /nu/thing, dire d’une des pièces jouées, une pièce qui était un peu minimaliste, mécanique et répétitive : « Pour moi, cette pièce n’a rien d’humain. » J’étais sur scène et j’ai pensé : « Mais on n’en a rien à foutre de l’humain. » Je veux dire, l’humain n’est pas un but en soi. L’humain est très intéressant, mais l’in-humain l’est tout autant.

Il y a aussi quelque chose dans la composition algorithmique qui se rapproche de l’idée de composition collective. Ce n’est pas un hasard si je collabore avec Andrea Valle, et que nous sommes parvenus à travailler si bien ensemble en partageant des algorithmes. Ces techniques obligent à faire un peu marche arrière par rapport à son propre ego. L’ordinateur met un filtre entre les résultats et notre sensibilité, notre culture, qui restent toujours là, évidemment.

Ce qui m’intéresse aussi, c’est qu’un algorithme correspond exactement à un style. C’est quelque chose qui se perd un peu, la notion du style, pouvoir reconnaître un style en quelques mesures de musique… Certains algorithmes que j’ai développés à la fin des années 90 ou au début des années 2000 donnent des résultats aux couleurs très spécifiques. Ça me fascine. D’ailleurs, ils ne sont pas très réutilisables car ils sonnent toujours un peu pareil…

Qu’est-ce qui caractériserait ton utilisation des techniques algorithmiques ?

Depuis presque 20 ans, les choses ont beaucoup évolué dans ma pratique de compositeur, mais certaines choses restent inchangées. Ces dernières années, la caractéristique principale consiste à essayer de trouver des systèmes qui gèrent des mécanismes de proximité entre objets sonores. J’ai ainsi développé, dans la pièce pour violoncelle, une fonction – un peu bricolée, comme c’est souvent le cas chez moi – qui donne un degré de proximité harmonique entre les objets. À partir de cette fonction, j’ai pu organiser des systèmes de recherche par bases de données ou essayer de créer des grands mouvements harmoniques, selon des principes qui rappellent un peu l’harmonie fonctionnelle. C’est très perceptible dans Ludus de Morte Regis, où on entend des piliers harmoniques bien définis, à l’intérieur desquels je recherche des enchaînements d’accords qui essaient d’être les plus lisses possible. Par exemple, à partir de deux accords, j’en recherche un troisième, harmoniquement exactement à mi-chemin, puis je renouvelle l’opération pour trouver deux nouveaux accords destinés à combler les nouvelles distances ainsi créées. Le mécanisme par contraintes arrive à ce moment-là, pour éviter qu’il y ait des accords qui se ressemblent trop. Des règles se rajoutent donc progressivement, et la solution n’est plus vraiment déterministe, c’est une chaîne de solutions possibles.

J’ai utilisé ce genre de système à plusieurs reprises, pour de la recherche harmonique, mais aussi pour de la recherche dans une base de données. Ainsi, la dernière pièce de Fossilia (dans Systema Naturae), est une recombinaison de toutes les pièces des trois Regnum, par une technique de synthèse concaténative avec de l’écriture symbolique. Toutes les pièces sont découpées par mesures, et on opère toutes les analyses en batch processing. Ensuite, à partir d’un choral de Bach qui est le point de référence caché, je recherche les accords qui correspondent le mieux. C’est donc une sorte de mosaïque, ce qui va bien avec l’idée du fossile, qui est lui-même une sorte de résumé de tous les autres royaumes du vivant, dans une structure morte et cristallisée, à la fois minérale, végétale et animale.

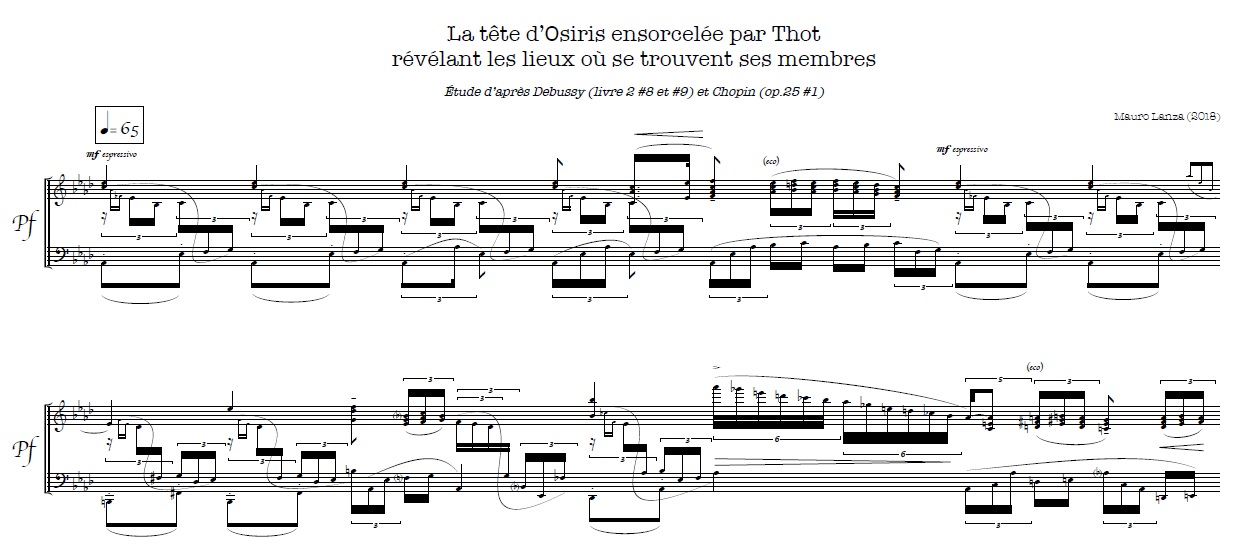

Un exemple plus récent est la pièce que je viens tout juste d’écrire et qui sera créée au festival Musica cette année. C’est presque un exercice conceptuel. Il s’agit d’une commande passée à plusieurs compositeurs pour des pièces servant d’interludes entre les Etudes de Debussy. Ma pièce doit s’insérer entre l’étude pour les agréments et l’étude pour les notes répétées. J’ai choisi une étude de Chopin, l’opus 25 no 1, et j’utilise le matériel issu des études de Debussy (en les transposant dans les 12 tons pour étendre la base de données). Ensuite, je recherche, pour chaque accord de Chopin, le meilleur candidat dans les deux études de Debussy, pour recomposer Chopin à partir de Debussy. Le résultat rappelle beaucoup certains exemples produit par le deep-learning dans le domaine visuel. Je citerais en exemple ce qu’un jeune compositeur napolitain, Claudio Panariello, m’a récemment montré : un hybride pictural nippo-napolitain qu’il a produit avec des librairies Google, en créant des images du Vésuve dans le style de Hokusai…

Pour ce qui concerne ma pièce qui hybride Debussy et Chopin, l’ordinateur s’est limité à me proposer les meilleurs candidats. C’est moi qui ai opéré le choix final de chaque séquence à partir de cette liste. Le principe de sélection de l’algorithme étant uniquement harmonique, le résultat brut ne fonctionnait pas parfaitement avec Chopin, je devais donc recomposer de façon plus musicale. Mais on retrouve parfois dans mes pièces des choses plus strictes, algorithmiquement parlant.

Justement, quelles seraient tes pièces algorithmiques les plus rigoureuses ?

Aucune de mes pièces n’est algorithmique d’un bout à l’autre, à quelques exceptions près. Ma pièce pour ensemble Sol, dédiée à Sol LeWitt, est algorithmique à 98%, disons. Seule l’orchestration n’est pas gérée par des algorithmes. L’idée de l’algorithme est très simple et m’a été inspirée par mon ami Francesco Filidei. Il s’agit d’une gamme diatonique, dont la disposition change en fonction de fondamentales harmoniques qui évoluent au cours de la pièce. C’est une musique très planante, avec des fade-in et fade-out, des enveloppes un peu soufflées, et tous les rythmes et les soufflets sont aussi gérés par des algorithmes.

Certains mouvements de Predella (pour orgue) sont aussi très poussés de ce point de vue là, notamment la deuxième pièce, qui est construite avec un principe d’hétérophonie à trois voix. Comme il s’agit d’une pièce pour orgue, les accents sont soulignés par la durée. La perception reconstitue à partir de ces trois voix, en filigrane, le dessin d’une gamme descendante. La 5e pièce de Predella est aussi algorithmique. Je pars d’une sorte de mélodie qui accélère au fur et à mesure, où les notes principales sont relayées par des arpèges générés sur des champs harmoniques.

Dans les pièces récentes, il y a des bouts de Ludus de Morte Regis qui sont très algorithmiques, notamment tout le passage assez délirant vers la fin de la première version, basé sur l’harmonie et le rythme d’une chanson anarchiste espagnole (Arroja la bomba), en forme de canon proliférant. Le processus de sélection des sons dans la base de données est strictement algorithmique.

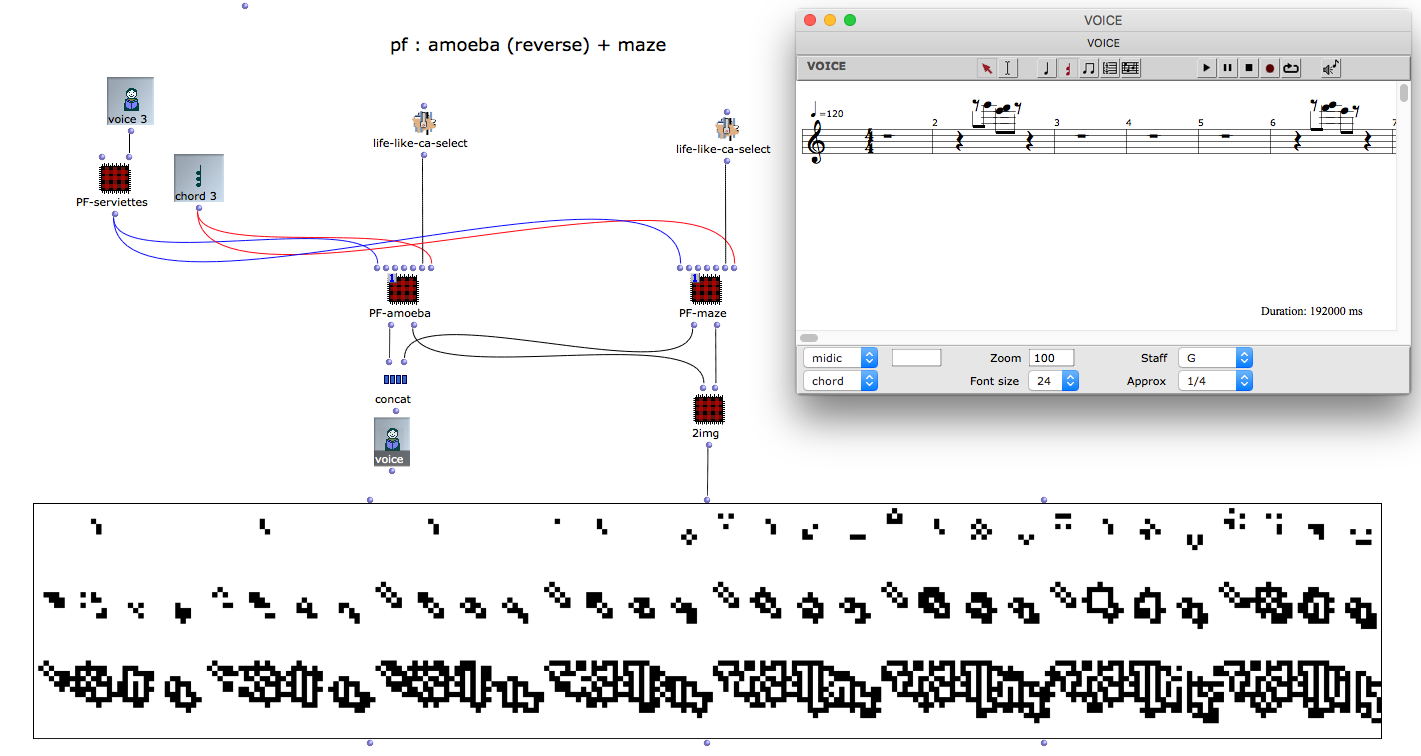

Et pour finir, tout le début de John Conway in gondola est réalisé avec des automates cellulaires. C’est une simulation dans Lisp du Jeu de la vie, donc d’automates cellulaires à deux états et deux dimensions, avec une matrice où le rythme correspond aux données horizontales et le vertical correspond aux notes. Les notes sont ordonnées soit par hauteurs, soit, plus intéressant, en fonction de leur ordre d’entrée dans un morceau de musique préexistant. Dans ce cas spécifique, j’ai pris comme point de départ la mélodie de O Sole Mio et j’ai donc ordonné les notes par rapport à leur entrée dans la mélodie. Ainsi, quand l’automate évolue, les motifs se développent généralement de façon progressive, car dans les automates cellulaires, une case ne se remplit jamais si elle est complètement éloignée des autres. On est donc toujours dans l’espace du modèle de référence, ce qui permet toujours de reconnaître la mélodie. J’ai utilisé les règles de Maze, qui fait exploser le nombre de notes, et de Life, où la tendance générale est plutôt à ce que les cellules finissent par mourir, sauf certaines configurations particulières. En renversant l’automate, cela produit un grand crescendo.

La compatibilité entre sons concrets et pensée algorithmique ne va pas toujours de soi. Tu sembles pourtant rechercher cette tension entre l’impureté des sonorités, le caractère délibérément anecdotique des sons, et le formalisme extrême de la musique. Lorsque tu commences une pièce, pars-tu plutôt du son, de l’algorithme, ou de l’articulation entre des deux ?

Les trois cas sont possibles. Dans la première partie de Ludus de Morte Regis, la problématique algorithmique et la typologie des sons sont strictement liées. Mon problème était : comment passer de la façon la plus rapide et la plus lisse de la voix chantée au pet ? Dans ce cas précis, l’algorithmique est vraiment au service du rendu sonore. Dans d’autres cas, je m’intéresse à cette friction entre une partition très stricte et déterminée, très mécanique, et des sons qui résistent à ce contrôle. C’est quelque chose qui m’intéresse beaucoup, et qui d’une certaine manière donne une certaine chaleur à la machine. Je ne dis pas que la machine est froide et a besoin de chaleur, mais le fait de travailler avec une certaine typologie de sons qui résistent à la partition me donne l’impression de travailler avec de l’analogique plutôt qu’avec du numérique. C’est un peu comme si je construisais un automate plutôt qu’une machine numérique sans défaut.

A propos de machines, une de tes pièces s’inspire de la machine de Kempelen, une autre du canard de Vaucanson… qu’est-ce qui t’intéresse tant dans les automates ?

Justement, la pièce sur le canard de Vaucanson (Anatra Digeritrice) est l’orchestration de 5 morceaux de Regnum animale, qui sont à l’origine pour radios, couteaux électriques et trio à cordes préparées… donc il s’agit déjà d’une transcription impossible.

J’ai grandi à un moment en Italie où travailler avec des systèmes processuels avait toujours quelque chose d’un peu honteux. Les compositeurs qui utilisaient ces techniques se justifiaient en disant : « oui, mais je retouche, c’est l’oreille qui compte, la part de l’intuition… » En prenant un peu de recul, on voit que ces remarques supposent des cases très rigides, où science et art occupent chacun une position figée, et où les deux mondes ne communiquent pas, ou bien s’ils communiquent, ce n’est pas vu d’un bon œil.

Je trouvais rafraîchissant de découvrir qu’il n’en avait pas toujours été ainsi. L’histoire de la science en Occident est loin d’être linéaire, et notamment au XVe – XVIe siècle, lorsqu’on évolue de la “magia naturalis” vers la science moderne proprement dite. Les allers-retours entre les deux sont ensuite incessants, jusqu’au XIXe siècle. L’âge d’or des automates est encore un moment où science, spectacle, illusionnisme, merveilles, ingénierie de bas et haut niveau, art, se mélangent sans arrêt. Et je me suis dit que les algorithmes et l’utilisation que je fais aujourd’hui des mathématiques se situent exactement dans cet espace-là. Je ne suis pas là pour faire des objets qui marchent, je suis là pour faire des objets qui émerveillent.

Ce que je trouvais intéressant dans la machine de Kempelen, c’est sa dimension à la fois spectaculaire, presque circassienne, et scientifique. Kempelen a écrit cette description d’une machine parlante qui est un véritable traité de phonétique articulatoire, très rigoureux, reflétant les connaissances de l’époque. À chaque fois que l’on construit un automate, se posent des questions épistémologiques relatives à la connaissance de l’homme, de l’être vivant, de l’animal. Jacques Vaucanson se posait déjà la question de la « machine molle »… Il avait l’ambitieux projet de construire un véritable automate d’être humain, mais cela ne l’empêchait pas de produire un pur canular tels le canard digéreur, le tout dans une seule et même démarche.

La machine de Kempelen se rapproche de ce que je disais à l’instant sur la friction entre contrôle numérique précis, partition idéale, et objets sonores qui résistent au traitement. Il y a une sorte de bégaiement touchant qui se produit quand des objets mécaniques se mettent en branle, surtout s’ils sont imparfaits. Toutes mes pièces avec Andrea sont orientées dans cette direction : les objets sont toujours sur le point de se casser, de faillir. Pour sa machine parlante, Kempelen a d’ailleurs choisi une voix d’enfant, aiguë et nasillarde, comme un enfant qui apprend à parler, non sans difficultés. C’est l’enfance de la machine.

Dans l’histoire (ou dans la préhistoire) de la musique algorithmique, de quel musicien te sentirais-tu le plus proche ? D’une manière plus générale, quels artistes, écrivains ou musiciens ont eu une importance décisive sur ton travail ?

Il m’est difficile de répondre car j’ai commencé à m’intéresser à l’histoire de la musique algorithmique bien après la mise en pratique. Évidemment, certaines figures m’ont influencé : c’est la lecture d’un article sur Horos de Xenakis qui m’a donné envie de travailler avec les automates cellulaires, par exemple. Les processus dans la musique spectrale ont aussi eu une grande influence sur moi, c’est même l’une des choses qui m’ont conduit en France, notamment par la figure de Gérard Grisey. Mais la plupart des références sont venues plus tard, dans le cadre des cours que j’ai donnés à l’Ircam ou à l’UdK de Berlin, où j’ai fait notamment une lecture de Musiques formelles de Xenakis. Mon intérêt pour Sol LeWitt, Pierre Barbaud, Iannis Xenakis, est donc plutôt arrivé a posteriori.

Quels sont tes projets actuels ? Certains font-ils écho à ces problématiques ?

En ce moment, je suis en train d’orchestrer un morceau du groupe de métal suédois Meshuggah, qui sera inséré comme hommage dans Systema Naturae, qui est un cycle rempli de clins d’œil à toutes sortes de musiques. Je dois aussi composer une nouvelle pièce d’orchestre, qui probablement aura comme point de départ des extraits de Mahler, mais aussi des structures harmoniques issues d’analyses de géométries engendrés avec la librairie d’éléments finis de Modalys (des accords issus des rubans de Möbius, par exemple).

Aujourd’hui, la ligne qui sépare composition et algorithmique devient pour moi tellement fine que je n’arrive plus à savoir où finit l’un et où commence l’autre. Je travaille toujours avec une fenêtre ouverte où il y a du code. C’est un environnement de travail, avec des allers-retours permanents.

(Propos recueillis en juillet 2018)

Page soundcloud de Mauro Lanza