Peux-tu te présenter et nous parler de ton parcours, et de ce qui t’a conduite à l’intéresser à la musique par intelligence artificielle et à la sonification ? Peux-tu nous parler de ton travail sur la musique générative via la sonification de texte ?

Je m’appelle Hannah Davis, et on peut retrouver mon travail sur HannahIsHere, Music from text et me suivre sur Twitter (@ahandvanish).

J’ai commencé à m’intéresser à la sonification pendant mon cursus ITP à l’Université de New York. Mon sujet de thèse y était un algorithme que j’ai appelé TransProse, destiné à transformer des livres en musique.

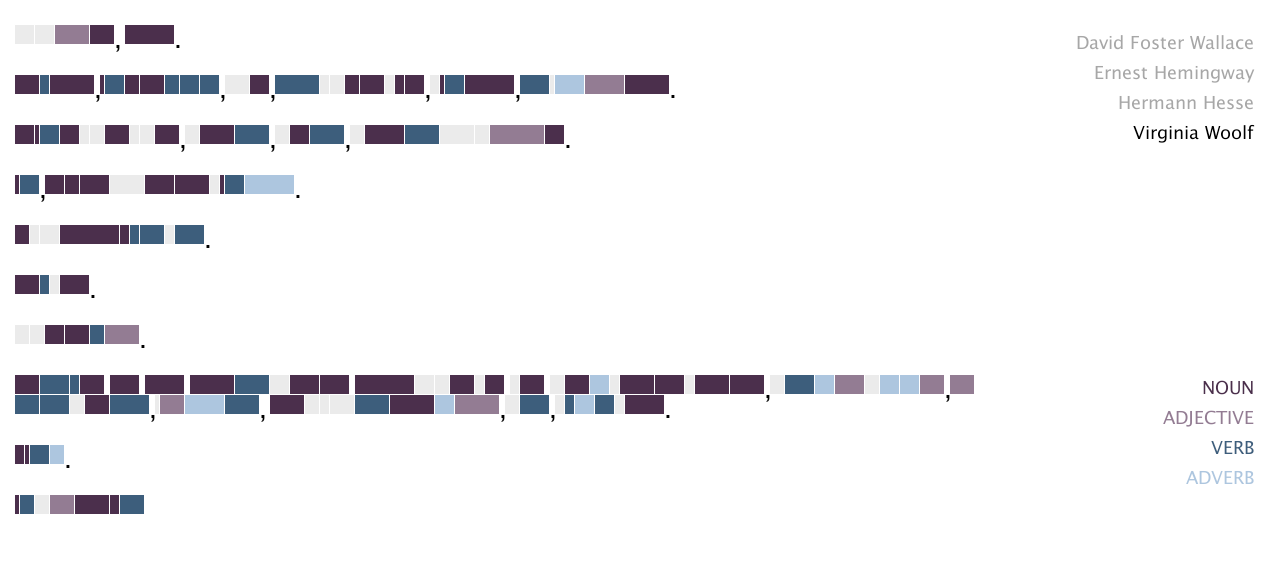

TransProse fonctionne en relevant les « niveaux d’émotion » tout au long d’un roman, et transforme ces données émotionnelles en musique par différents mappings. Par exemple, on peut influencer le registre aigu ou grave en fonction de la tristesse ou de la colère, ou relier le tempo au caractère plus ou moins actif ou passif des émotions, et à la quantité d’actions. Il y a un grand nombre de manières de mapper l’émotion en musique ; c’est très subjectif.

Pendant plusieurs années après ça, j’ai travaillé sur la visualisation de données, puis je me suis concentrée sur la sonification. Je me suis toujours intéressée à la musique – lorsque j’étais plus jeune, je jouais dans un ensemble de flûtes baroques, et j’ai ensuite joué beaucoup de percussion et de guitare. Mon intérêt pour la musique générative était donc une voie naturelle.

Quel intérêt a pour toi la sonification de données, comparée à la visualisation de données ?

La sonification de données a plusieurs atouts par rapport à la visualisation : c’est très efficace pour les données qui se déroulent dans le temps, pour tout ce qui est multi-dimensionnel, et pour tout ce qui présente des cycles. Cela permet très facilement d’entendre les motifs récurrents dans un ensemble de données. C’est très approprié pour les petites unités. Ma réalisation préférée dans ce genre est la sonification des résultats olympiques par Amanda Cox pour le New York Times il y a quelques années.

Il est aussi possible de créer des musiques intéressantes avec des données ; j’aime particulièrement l’ensemble de pièces de James Murphy qui utilise des données issues de matches de tennis.

C’est aussi très adapté pour les données émotionnelles, car le son et la musique sont d’excellents vecteurs d’émotions.

Il y a un lien entre le poids statistique d’un mot dans une langue donnée (loi de Zipf) et l’équilibre entre prédictibilité et imprédictibilité, par exemple avec le bruit 1/f. Est-ce ce genre de principes esthétiques qui t’ont conduite à t’intéresser à la création de musique d’après des textes ?

Je suis très intéressée par ces idées, mais elles ne jouent pas de rôle déterminant dans mon travail. Les caractéristiques avec lesquelles je travaille se situent à un plus grand niveau d’abstraction, telles que les émotions.

Les paramètres que tu utilises pour transcrire les émotions (majeur/joyeux, agité/tempo rapide…) ne risquent-ils pas de nuire à la complexité de la musique produite ainsi ? Comment envisages-tu cette problématique ?

Je cherche à atteindre cette complexité en créant des mappings et des paramètres qui contiennent déjà de la complexité. Une des choses que j’essaie de ne pas faire est de tronquer les données : par exemple, si le mot “joie” est l’émotion la plus forte du texte, je ne fais pas une pièce uniquement joyeuse, mais j’utilise un ratio de joie mélangée à d’autres émotions. Il est difficile de généraliser et de créer toujours des pièces complexes, mais mon travail est itératif, et ne cesse de s’améliorer…

Je n’ai pas encore utilisé de machine-learning dans mes programmes « text-to-music », mais j’ai quelques idées. Ce sera intéressant de pouvoir comparer le résultat obtenu par une approche en machine-learning et par mon programme actuel.

Dirais-tu que n’importe quel jeu de données peut générer de la musique intéressante ?

Oui, je le crois sincèrement. Mais je crois aussi que 100% du résultat repose sur la personne qui fait la sonification. J’aime vraiment travailler avec des romans et d’autres données textuelles qui se déroulent dans le temps, car pour moi ils présentent une succession très naturelle de pics et de plaines, d’apogées, de conclusions, qui aident à créer une musique qui sonne naturellement.

Peux-tu nous parler de tes “bots” sur Twitter ?

Il y a une communauté très active de bots créatifs sur Twitter : certains écrivent des poèmes, d’autres génèrent de superbes images, apportant ainsi une sorte de sérendipité à votre journée. J’ai conçu un cours en ligne sur les bots Twitter pour attirer l’attention sur cette forme d’expression, et j’ai créé un « pipeline » afin que des bots Twitter sonores puissent se créer.

En effet, Twitter ne permet pas nativement de diffuser des fichiers audio, donc mon code permet de prendre un bout de musique générée automatiquement, de l’associer à une image, et de télécharger sur Twitter comme une vidéo. Le premier robot que j’ai fait sur Twitter prenait les tweets de @Pentametron, qui est lui-même un célèbre robot Twitter, et créait des fragments audio qui répondaient à chacun de ses tweets.

La plupart des bots sont hors ligne actuellement, mais le code est disponible en ligne.

Comment se passent tes collaborations avec des compositeurs, notamment avec celle avec Mathieu Lamboley dans le cadre du projet Accenture ?

Ce fut une collaboration de courte durée mais très agréable. J’ai généré trois pièces basées sur des articles d’actualités, sur différents thèmes, comme par exemple l’essor de la technologie. Les pièces générées duraient chacune entre 1 et 2 minutes, pour piano seul. Mathieu Lamboley a ensuite pris ces pièces et les a enrichies pour en faire une symphonie en trois mouvements pour grand orchestre, qui a été jouée au Louvre à Paris et au musée BMW de Munich.

Un peu à la manière des improvisations que les pianistes exécutaient pour accompagner les films aux débuts du cinéma, l’un de tes projets actuels est de créer un logiciel qui génère automatiquement de la musique en lien avec des images vidéos. Peux-tu nous en dire davantage ?

Ce projet n’en est qu’à ses balbutiements ! En raison de mon travail déjà accompli sur la création de musique d’après des textes, j’ai la conviction qu’on peut en faire autant avec des vidéos. Le processus de composition serait très différent : au lieu de créer une pièce d’une heure représentant une seule œuvre, comme je le fais avec un roman, la musique se déroulerait selon la même temporalité que la vidéo. Les contraintes et objectifs serait de compléter le film, pas nécessairement de le traduire en musique. J’attends des subventions pour faire un prototype, nous verrons bien ce que ça donne…

Le domaine des applications de la musique composée par intelligence artificielle est assez large (musiques générées pour les vidéos amateurs sur Youtube, jeux vidéos…). Comment vois-tu le futur de tout ça ?

Il y a à boire et à manger ! Je ne suis pas très intéressée par les musiques à tout faire, surtout lorsqu’il s’agit de se débarrasser des musiciens en chair et en os, et j’espère que ce n’est pas la tournure que prennent les choses. D’un autre côté, je pense qu’il y a une aire de jeu nouvelle et passionnante pour les programmeurs-compositeurs sur la création de musiques pour le cinéma ou le jeu vidéo. J’aimerais que l’accent soit mis sur les humains qui utilisent les IA pour créer de nouveaux types de musiques, et moins sur les humains qui écrivent des programmes qui génèrent de la musique au kilomètre qui sonne toujours de la même manière.

As-tu des défis dans ce domaine ?

Mon principal défi est que, comme il s’agit encore d’une certaine manière d’une discipline émergente, les logiciels et outils pour créer de la musique d’après des données et d’autres informations n’existent pas encore réellement. Cela rend difficile pour les musiciens non-programmeurs de s’approprier et d’exploiter ces idées nouvelles. Ce serait formidable de voir ce type de logiciels se développer davantage.

(Propos recueillis en mars 2018 – English version)